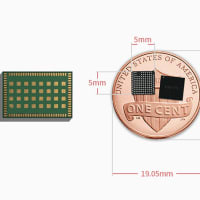

Edge TPUはTensorFlow Liteモデルのみと互換性があります。 そのため、TensorFlowモデルをトレーニングし、TensorFlow Liteに変換し、Edge TPU用にコンパイルする必要があります。 次に、このページで説明されているオプションのいずれかを使用して、Edge TPUでモデルを実行できます。(Edge TPUと互換性のあるモデルの作成の詳細については、Edge TPUのTensorFlowモデルをご覧ください。 https://coral.ai/docs/edgetpu/models-intro/)

Pythonで推論を実行する

Pythonを使用して推論を実行している場合、2つのオプションがあります。

TensorFlow Lite APIを使用します:

これは、TensorFlow Liteモデルを実行する従来のアプローチです。 データの入出力を完全に制御できるため、さまざまなモデルアーキテクチャで推論を実行できます。

TensorFlow Liteを以前に使用したことがある場合、Interpreterコードはごくわずかな変更を加えるだけでエッジTPUでモデルを実行できます。(詳細については、PythonでTensorFlow Liteを使用して推論を実行するをご覧ください。

TensorFlow Liteを以前に使用したことがある場合、Interpreterコードはごくわずかな変更を加えるだけでエッジTPUでモデルを実行できます。(詳細については、PythonでTensorFlow Liteを使用して推論を実行するをご覧ください。

Edge TPU APIを使用します:

これは、TensorFlow Lite C ++ APIの上に構築されたPythonライブラリであるため、画像分類モデルとオブジェクト検出モデルを使用して、より簡単に推論を実行できます。

このAPIは、TensorFlow Lite APIの経験がなく、単に画像分類またはオブジェクト検出を実行する場合に役立ちます。入力テンソルの準備と結果の解析に必要なコードを抽象化するためです。 また、Edge TPUで分類モデルの高速転送学習を実行する独自のAPIも提供します。(詳細については、Edge TPU Python APIの概要をご覧ください。

C ++で推論を実行する

C ++でコードを記述したい場合は、他のプラットフォームでTensorFlow Liteを実行するのと同じように、TensorFlow Lite C ++ APIを使用する必要があります。 ただし、edgetpu.hまたはedgetpu_c.hファイルのAPIを使用して、コードにいくつかの変更を加える必要があります。 基本的に、Interpreterオブジェクトの外部コンテキストとしてEdge TPUデバイスを登録するだけです。(詳細については、「C ++でTensorFlow Liteで推論を実行する」を参照してください。

Coral Acceleratorモジュールは、2020年初頭にCoral Webサイトで販売されます。Google Coral製品、および大量販売または大量販売(ボリュームディスカウント)の詳細に興味がある場合は、ようこそCoral 海外代理店 Gravitylink : https://store.gravitylink.com/global

※コメント投稿者のブログIDはブログ作成者のみに通知されます