Googleは、Raspberry Pi機器を画像認識デバイスに変えることができるAIY(AI自分)ビジョンキットを発売しました。 ビジョンキットはGoogleのTensorFlow機械学習モデルを搭載しており、まもなくデバイスを制御するためのAndroidアプリが付属します。

AIY音声プロジェクトも導入しました。これにより、メーカーはGoogle Assistant SDKを使用して、Raspberry Piを音声制御アシスタントに変えることができました。

Vision Kit は「オンデバイスニューラルネットワークアクセラレーション」を特長としており、Raspberry Piベースのボックスでクラウドで処理せずにコンピュータービジョンを実行できます。 AIY Voice Kitは、自然言語処理をクラウドに依存しています。

キットには、最大1000種類のオブジェクトを認識できるオブジェクト認識アプリケーション、顔とその表情を認識するオブジェクト認識アプリケーション、人、猫、犬を検出する3つのアプリケーションがあります。 それだけで多くのいたずらをすることができますが、独自のニューラルネットワークを実行することもできます。

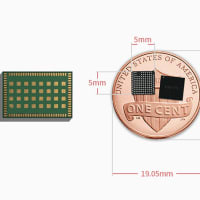

VisionBonnetボードはGoogleによって開発され、IntelのMovidius MA2450ビジョン処理チップを搭載しています。 このチップは、Vision Kitの秘密のソースです。 Raspberry Pi 3に依存する場合よりもコンピュータービジョンの実行が60倍速くなります。VisionBonnetは、キットに付属のケーブルでRaspberry Pi Zero Wに接続されます。

Googleは、開発者がこれらのニューラルネットワークを構築し、猫/犬/人の検出器にウサギを認識させるなどの新しいタスクに適用することを望んでいます。 この目標を達成するために、TensorFlowでモデルを再トレーニングするためのモデルをコンパイルするツールが提供されています。

Vision Kitは、Googleディストリビュータ Gravitylink から89.99ドルで入手できます。

※コメント投稿者のブログIDはブログ作成者のみに通知されます