Webスクレイピングと言えば、思わずWeb内容をスクレイピングして偽オリジナルに発表するとか、個人アカウントをスクレイピングしてネットマーケティングするなどを連想しています。実際、これまでデータ収集技術の開発が適用されてきましたが、多くの企業の概念は依然として最も原始的な印象にとどまっています。古い概念は、データ収集技術に対する非常に大きな誤解があるため、データ収集の価値は常に過小評価されています。

今回はAmazonを例として、経営者にとってデータ収集とビッグデータ適用の意味を紹介します。

1.消費者の好みを掘り起こす

ユーザさんの好みを調査するため、ほどんどの経営者は一部のサンプルを抽出して分析します。サンプルの抽出にはデータ数が足りないの原因で、偶に消費者の好みを完全に表現できない場合があリます。また、現在、情報は非常に急速に普及されており、サンプルデータがリアルタイムであるかどうかも経営者が考慮する重要なポイントです。

ScrapeStormを通じて、より多くのデータ収集及びデータ分析して、消費者の好みをより深く了解できます。消費者のニーズを知ることによってのみ、経営者は市場の方向性をよりよく把握できます。

例えば、Amazonの商品レビュアー、買主の地域などの公開情報を分析して、自分の商品の理想的な販売エリア、商品の不足などを把握でき、目安を付けて、消費者に正確な情報を提供します。マーケティング効率を大幅に改善します。

Amazonをスクレイピングの詳細については、ここをクリックしてください。

2.相手の情報を把握する

敵を知り己を知らば、百戦危うからずということわざがあります。只今、各業界の競争は段々激しくになります。ビッグデータの収集と分析には、相手の動きを把握すれば先制できます。広告配信、市場シェアの配分などに役立ち、優れたデータ分析は、業界を導くことができます。

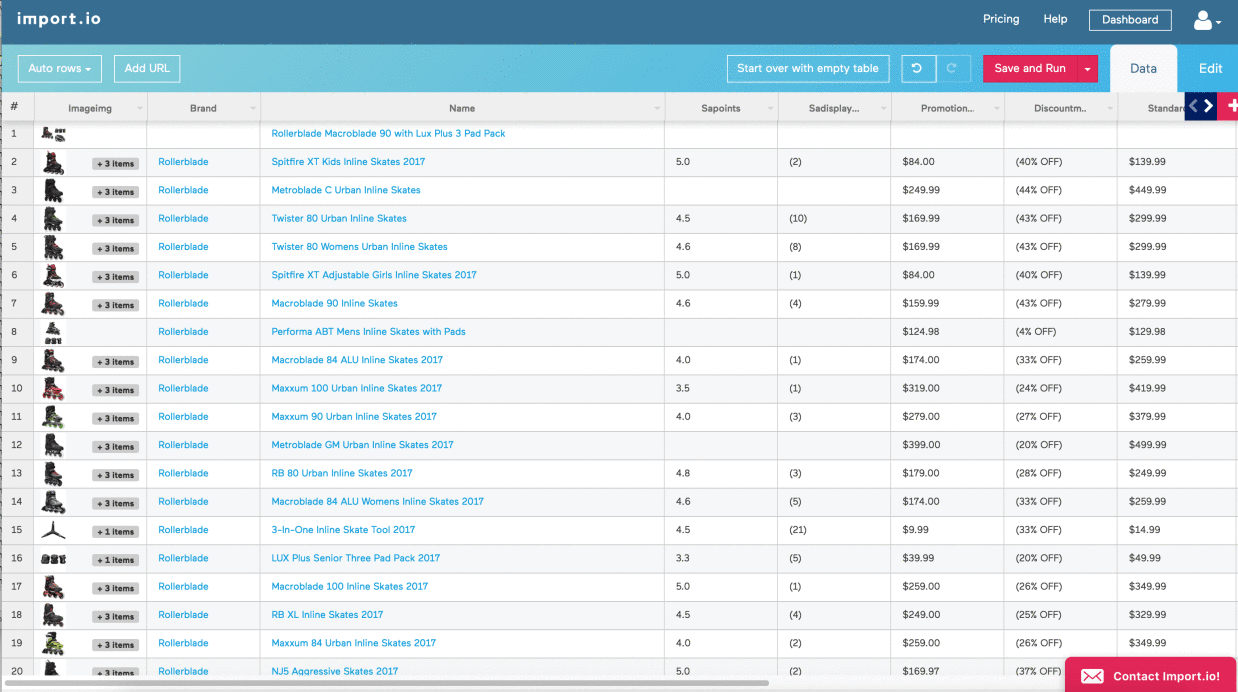

Amazonで同類商品情報を収集して、商品の価格、デザインなどによって、経営している商品を改善できます。

3.人気のホットトピックスをマスターする

流行りを乗るのは非常に有効的なマーケティング手段です。但し、ニュースを見るだけのは全然足りないでしょう。Twitterなどのソーシャルメディアをスクレイピングして、人々は今何を夢中しているのがさっぱり分かります。現在の流行りをつかむことは、会社の宣伝に大きく助けることができます。

Amazonのマーケティングにはデータの把握が欠かせないです。ScrapeStormは、人工知能を基づき、プログラミングしなくても、ほとんどのWebサイトからデータを抽出できると言うWebスクレイピングツールとして必ずデータ収集に役立ちます。

今回はAmazonを例として、経営者にとってデータ収集とビッグデータ適用の意味を紹介します。

1.消費者の好みを掘り起こす

ユーザさんの好みを調査するため、ほどんどの経営者は一部のサンプルを抽出して分析します。サンプルの抽出にはデータ数が足りないの原因で、偶に消費者の好みを完全に表現できない場合があリます。また、現在、情報は非常に急速に普及されており、サンプルデータがリアルタイムであるかどうかも経営者が考慮する重要なポイントです。

ScrapeStormを通じて、より多くのデータ収集及びデータ分析して、消費者の好みをより深く了解できます。消費者のニーズを知ることによってのみ、経営者は市場の方向性をよりよく把握できます。

例えば、Amazonの商品レビュアー、買主の地域などの公開情報を分析して、自分の商品の理想的な販売エリア、商品の不足などを把握でき、目安を付けて、消費者に正確な情報を提供します。マーケティング効率を大幅に改善します。

Amazonをスクレイピングの詳細については、ここをクリックしてください。

2.相手の情報を把握する

敵を知り己を知らば、百戦危うからずということわざがあります。只今、各業界の競争は段々激しくになります。ビッグデータの収集と分析には、相手の動きを把握すれば先制できます。広告配信、市場シェアの配分などに役立ち、優れたデータ分析は、業界を導くことができます。

Amazonで同類商品情報を収集して、商品の価格、デザインなどによって、経営している商品を改善できます。

3.人気のホットトピックスをマスターする

流行りを乗るのは非常に有効的なマーケティング手段です。但し、ニュースを見るだけのは全然足りないでしょう。Twitterなどのソーシャルメディアをスクレイピングして、人々は今何を夢中しているのがさっぱり分かります。現在の流行りをつかむことは、会社の宣伝に大きく助けることができます。

Amazonのマーケティングにはデータの把握が欠かせないです。ScrapeStormは、人工知能を基づき、プログラミングしなくても、ほとんどのWebサイトからデータを抽出できると言うWebスクレイピングツールとして必ずデータ収集に役立ちます。