Webスクレイピングとは?

WikiからのWebスクレイピングの説明をご参照ください。

Webスクレイピング(英: Web scraping)とは、ウェブサイトから情報を抽出するコンピュータソフトウェア技術のこと。ウェブ・クローラーあるいはウェブ・スパイダーとも呼ばれる。 通常このようなソフトウェアプログラムは低レベルのHTTPを実装することで、もしくはウェブブラウザを埋め込むことによって、Webのコンテンツを取得する。

ウェブスクレイピングは多くの検索エンジンによって採用されている、ボットを利用してウェブ上の情報にインデックス付けを行うウェブインデクシングと密接な関係がある。ウェブスクレイピングではウェブ上の非構造化データの変換、一般的にはHTMLフォーマットからデータベースやスプレッドシートに格納・分析可能な構造化データへの変換に、より焦点が当てられている。また、コンピュータソフトウェアを利用して人間のブラウジングをシミュレートするウェブオートメーションとも関係が深い。ウェブスクレイピングの用途は、オンラインでの価格比較、気象データ監視、ウェブサイトの変更検出、研究、ウェブマッシュアップやウェブデータの統合等である。

今回はWebスクレイピングを目指す、五つの無料のソフトウェア型スクレイピングツールを紹介する。

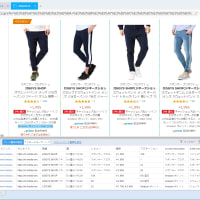

1.ScrapeStorm

ScrapeStormは、人工知能を基づき、プログラミングしなくても、ほとんどすべてのWebサイトからデータを抽出できると言うWebスクレイピングツールである。

強い機能を持って、使いやすいだ。URLを入力だけで、自動的に抽出するデータと次のページボタンを識別できる。複雑なルール設定が必要ないし、1‐Clickでスクレイピンができる。

ScrapeStormは、Windows、Mac、およびLinuxに適応するソフトウェアである。Excel、HTML、Txt、CSVなどのさまざまなファイル形式で結果をダウンロードできる。 さらに、データベースやウェブサイトにデータをエクスポートできる。

2.ParseHub

ParseHubは、誰でもWebからデータを取得する、視覚的なデータ抽出ツールである。

Webスクレイパーを再度編成する必要がない。APIを持たないWebサイトからAPIを簡単に作成できる。ParseHubは、インタラクティブなマップ、カレンダー、検索、フォーラム、ネストされたコメント、無限スクロール、認証、ドロップダウン、フォーム、Javascript、Ajaxなどを簡単に処理できる。ParseHubは、全員向けの無料プランと、大規模なデータ抽出ニーズがあり企業向けのエンタープライズプランを提供する。

3.Cyotek WebCopy

「Cyotek WebCopy」は、Webサイトのコンテンツをローカルディスクへコピーできるソフト。 指定したWebサイトのコンテンツをスキャンしてURLの一覧を取得したり、ローカルディスクへダウンロードすることが可能。自分のサイトにリンク切れがないかチェックしたり、サイトのバックアップを作成したり、オフラインで閲覧するためにコピーをとったりするのに利用できる。

4.HTTrack

HTTrackは、GNU General Public LicenseのVer3ライセンスで公開している、オープンソースのWebクローラ及びオフラインブラウザである。 World Wide Web上のサイトをインターネット経由でローカル環境にダウンロードが可能であり、初期設定ではオリジナルのサイトの相対的なリンク構造に基づき各ファイルを配置している。 また、既存のミラーサイトを更新して中断したダウンロードを再開できる。 基本的なCUIと2種類WebHTTrackのGUIによる操作が可能であり、CUIはスクリプトやcronに組み込みが可能である。 クローラはRobots Exclusion Standardによりダウンロード出来ない場合もある。 基本的なJavaScriptやアプレット及びAdobe Flash内部のリンクもダウンロード可能であるが、式やサブルーチンにより生成された複雑なリンクは無効化される。

5.Getleft

Getleft Web サイト グラバーは、すべてのリンクをダウンロードしようとする。それが行くように、それは絶対リンクを相対リンクに変更を取得するように元のHTMLページを変更して、アクティブなページへのリンクは、結果のページに変更を取得。ユーザーが設定したオプションに従って完全な web サイトをダウンロードする。

WikiからのWebスクレイピングの説明をご参照ください。

Webスクレイピング(英: Web scraping)とは、ウェブサイトから情報を抽出するコンピュータソフトウェア技術のこと。ウェブ・クローラーあるいはウェブ・スパイダーとも呼ばれる。 通常このようなソフトウェアプログラムは低レベルのHTTPを実装することで、もしくはウェブブラウザを埋め込むことによって、Webのコンテンツを取得する。

ウェブスクレイピングは多くの検索エンジンによって採用されている、ボットを利用してウェブ上の情報にインデックス付けを行うウェブインデクシングと密接な関係がある。ウェブスクレイピングではウェブ上の非構造化データの変換、一般的にはHTMLフォーマットからデータベースやスプレッドシートに格納・分析可能な構造化データへの変換に、より焦点が当てられている。また、コンピュータソフトウェアを利用して人間のブラウジングをシミュレートするウェブオートメーションとも関係が深い。ウェブスクレイピングの用途は、オンラインでの価格比較、気象データ監視、ウェブサイトの変更検出、研究、ウェブマッシュアップやウェブデータの統合等である。

今回はWebスクレイピングを目指す、五つの無料のソフトウェア型スクレイピングツールを紹介する。

1.ScrapeStorm

ScrapeStormは、人工知能を基づき、プログラミングしなくても、ほとんどすべてのWebサイトからデータを抽出できると言うWebスクレイピングツールである。

強い機能を持って、使いやすいだ。URLを入力だけで、自動的に抽出するデータと次のページボタンを識別できる。複雑なルール設定が必要ないし、1‐Clickでスクレイピンができる。

ScrapeStormは、Windows、Mac、およびLinuxに適応するソフトウェアである。Excel、HTML、Txt、CSVなどのさまざまなファイル形式で結果をダウンロードできる。 さらに、データベースやウェブサイトにデータをエクスポートできる。

2.ParseHub

ParseHubは、誰でもWebからデータを取得する、視覚的なデータ抽出ツールである。

Webスクレイパーを再度編成する必要がない。APIを持たないWebサイトからAPIを簡単に作成できる。ParseHubは、インタラクティブなマップ、カレンダー、検索、フォーラム、ネストされたコメント、無限スクロール、認証、ドロップダウン、フォーム、Javascript、Ajaxなどを簡単に処理できる。ParseHubは、全員向けの無料プランと、大規模なデータ抽出ニーズがあり企業向けのエンタープライズプランを提供する。

3.Cyotek WebCopy

「Cyotek WebCopy」は、Webサイトのコンテンツをローカルディスクへコピーできるソフト。 指定したWebサイトのコンテンツをスキャンしてURLの一覧を取得したり、ローカルディスクへダウンロードすることが可能。自分のサイトにリンク切れがないかチェックしたり、サイトのバックアップを作成したり、オフラインで閲覧するためにコピーをとったりするのに利用できる。

4.HTTrack

HTTrackは、GNU General Public LicenseのVer3ライセンスで公開している、オープンソースのWebクローラ及びオフラインブラウザである。 World Wide Web上のサイトをインターネット経由でローカル環境にダウンロードが可能であり、初期設定ではオリジナルのサイトの相対的なリンク構造に基づき各ファイルを配置している。 また、既存のミラーサイトを更新して中断したダウンロードを再開できる。 基本的なCUIと2種類WebHTTrackのGUIによる操作が可能であり、CUIはスクリプトやcronに組み込みが可能である。 クローラはRobots Exclusion Standardによりダウンロード出来ない場合もある。 基本的なJavaScriptやアプレット及びAdobe Flash内部のリンクもダウンロード可能であるが、式やサブルーチンにより生成された複雑なリンクは無効化される。

5.Getleft

Getleft Web サイト グラバーは、すべてのリンクをダウンロードしようとする。それが行くように、それは絶対リンクを相対リンクに変更を取得するように元のHTMLページを変更して、アクティブなページへのリンクは、結果のページに変更を取得。ユーザーが設定したオプションに従って完全な web サイトをダウンロードする。

※コメント投稿者のブログIDはブログ作成者のみに通知されます