Webスクレイピングツールは、Webサイトからな情報を抽出するために特別に開発されたソフトウェアです。 これらのツールは、インターネットから何らかの形式のデータを収集しようとしている人にとって便利です。これから、2020年に潜在力を満たすWebスクレイピングツールを紹介します。

1.ScrapeStorm

ScrapeStormとは、強い機能を持つ、プログラミングが必要なく、使いやすく人工知能Webスクレイピングツールです。違う基盤のユーザーに二つのスクレイピングモードを提供し、1-Clickで99%のWebスクレイピングを満たします。ScrapeStormにより、大量のWebデータを素早く正確的に取得できます。手動でデータ抽出が直面するさまざまな問題を完全に解決し、情報取得のコストを削減し、作業効率を向上させます。

2.VisualScraper

VisualScraperは、Webから情報を収集するために使用するWebスクレイピングツールです。 このソフトウェアは、複数のWebページからデータを抽出し、リアルタイムで結果を取得するのに役立ちます。 さらに、CSV、XML、JSON、SQLなどのさまざまな形式でエクスポートできます。月額49ドルから10万ページ以上のページにアクセスできるプレミアムプランに加えて無料で提供されます。 Parsehubと同様の無料のアプリケーションは、C ++パッケージが追加されたWindowsで利用できます。

3.Spinn3r

Spinn3rでは、ブログ、ニュース&ソーシャルメディアサイト、RSS&ATOMフィードからデータ全体を取得できます。インデックス作成作業の95%を管理するfirehouse APIとともに配布されます。 高度なスパム保護を提供します。これにより、スパムや不適切な言語の使用が削除され、データの安全性が向上します。Spinn3rは、Googleに似たコンテンツのインデックスを作成し、抽出したデータをJSONファイルに保存します。

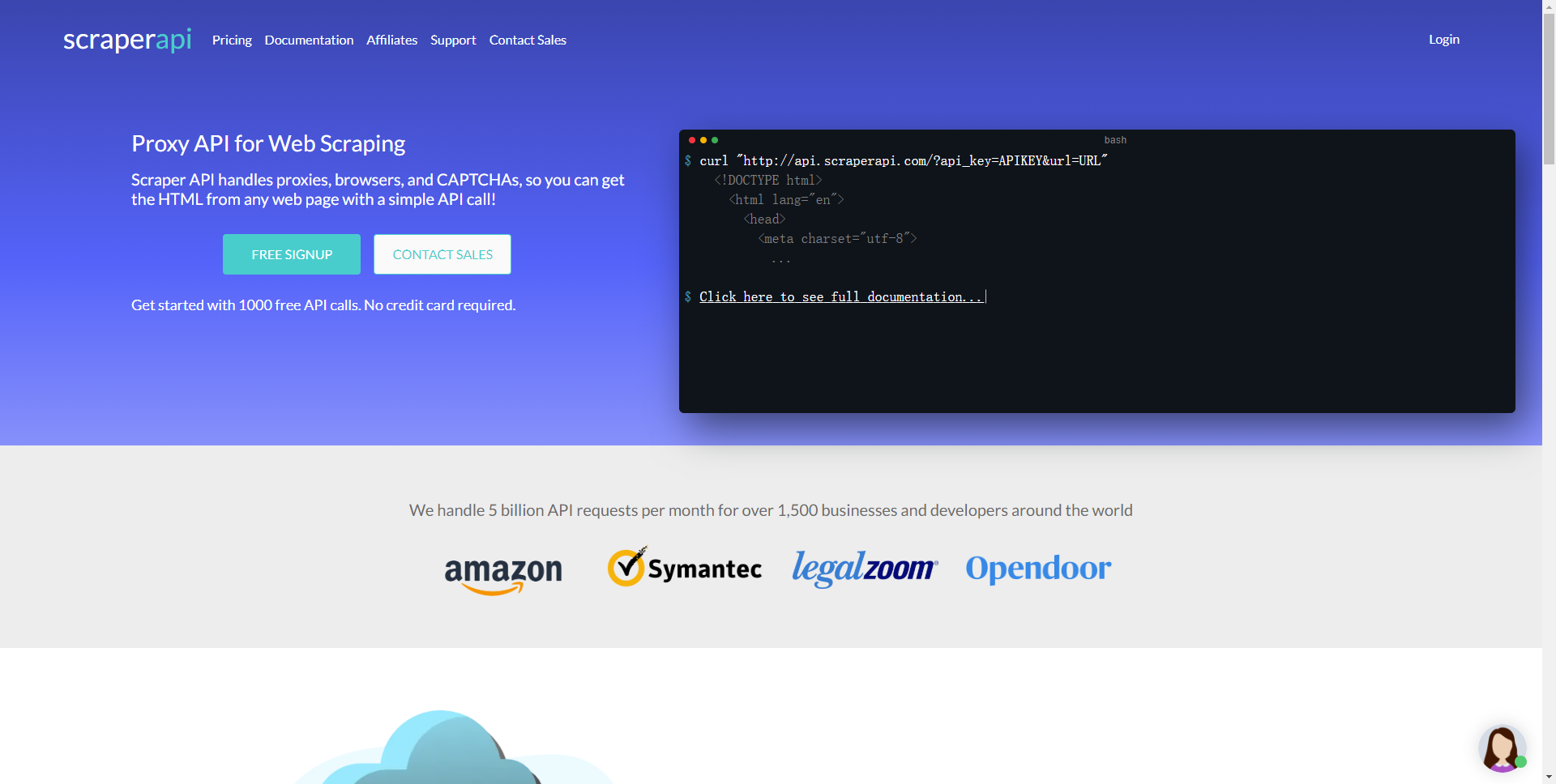

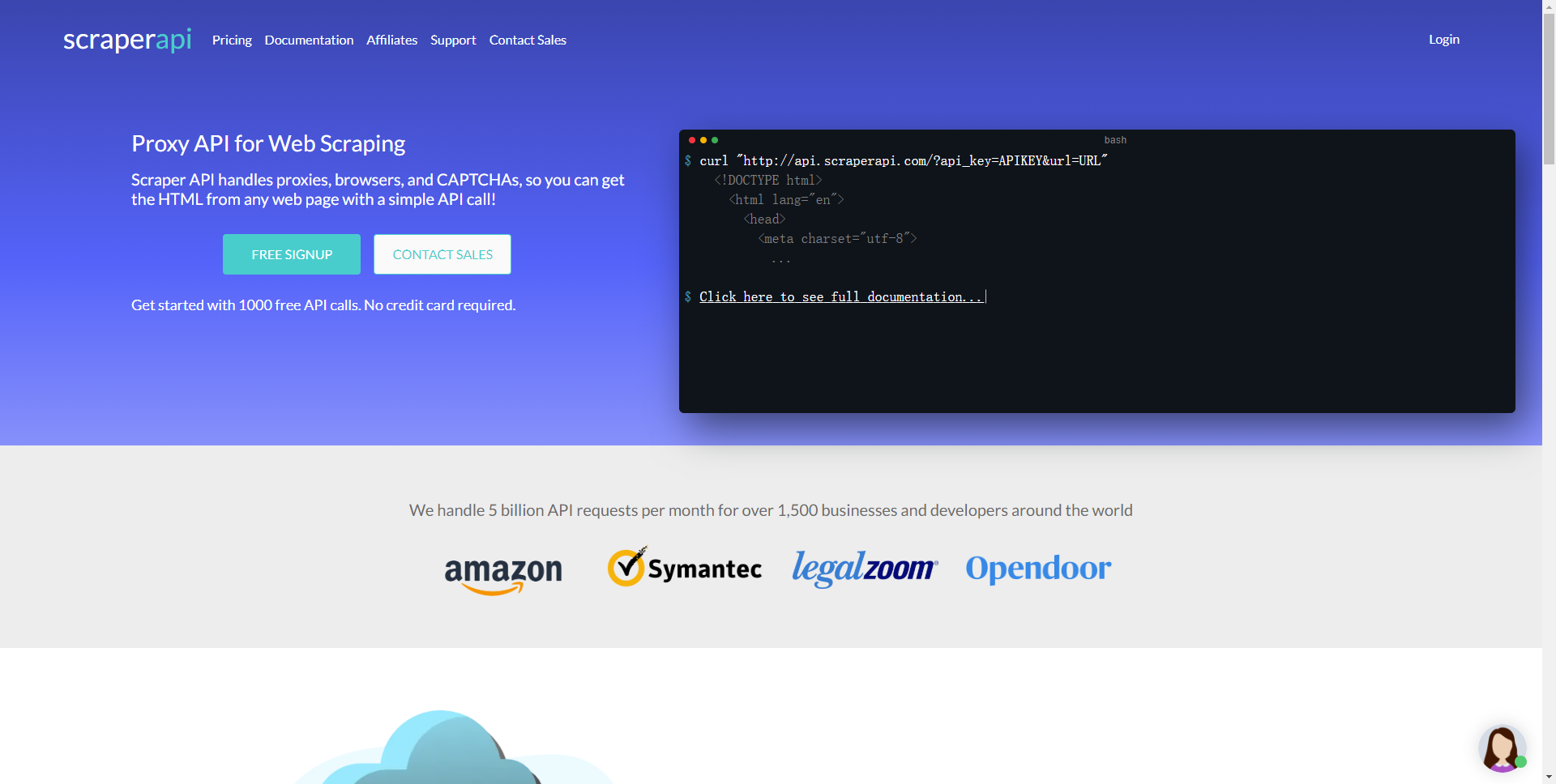

4.Scraper API

Scraper APIツールは、プロキシ、ブラウザ、CAPTCHAの管理に役立ちます。 これにより、簡単なAPI呼び出しでWebページからHTMLを取得できます。 APIキーとURLを使用してAPIエンドポイントにGETリクエストを送信するだけでよいため、統合は簡単です。

5.ScrapeSimple

ScrapeSimpleは、カスタムスクレーパーを作成したい人に最適なサービスです。 Webスクレイピングは、必要なデータの種類に関する指示をフォームに入力するだけで簡単に作成できます。

ScrapeSimpleは、顧客向けのカスタムWebスクレーパーを構築および管理する完全に管理されたサービスで、その名の通りに機能します。 どのサイトからどのような情報が必要かを伝えるだけで、カスタムWebスクレイパーを設計して、CSV形式で定期的に(毎日、毎週、毎月など)情報を受信トレイに直接配信します。

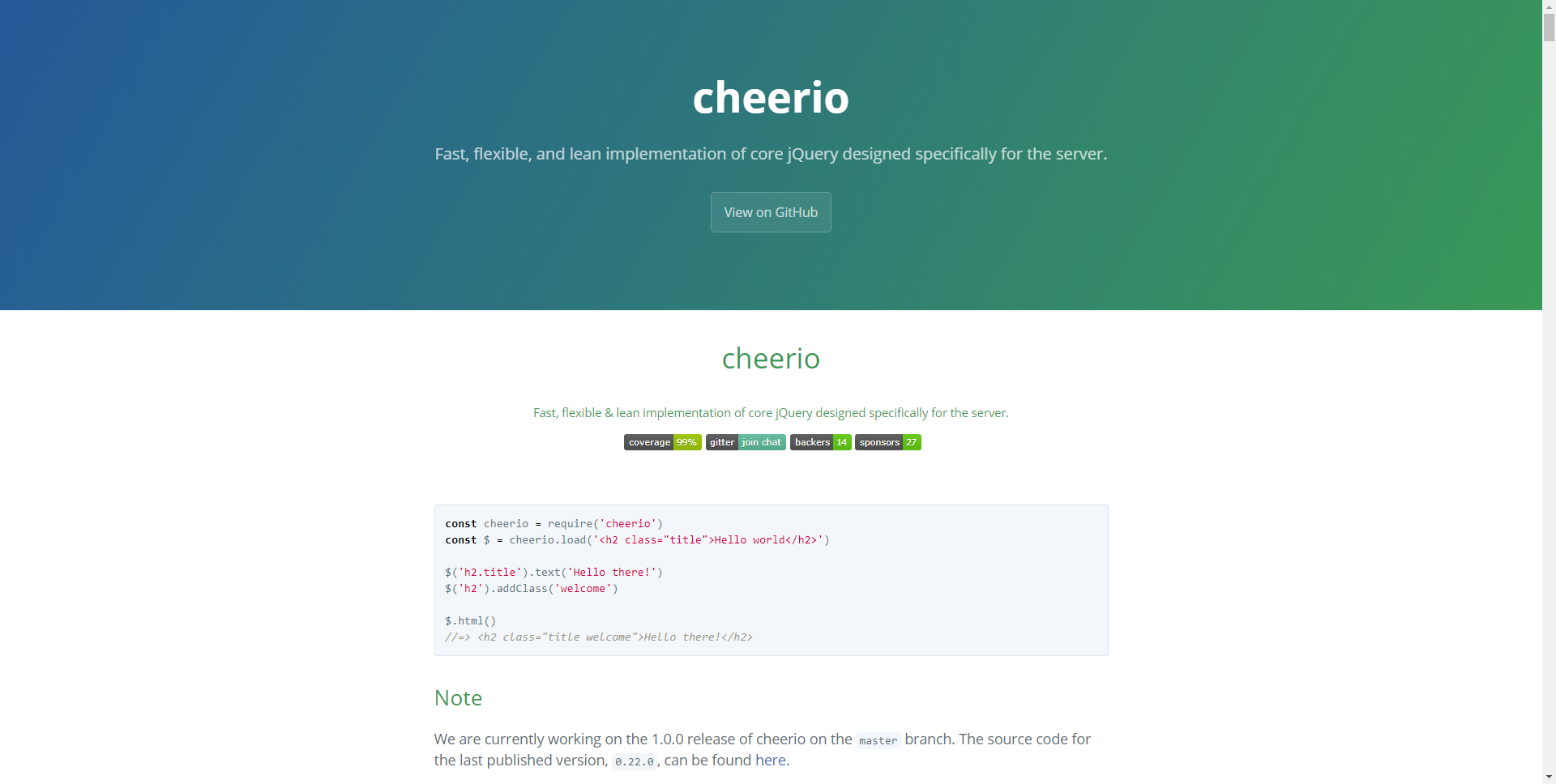

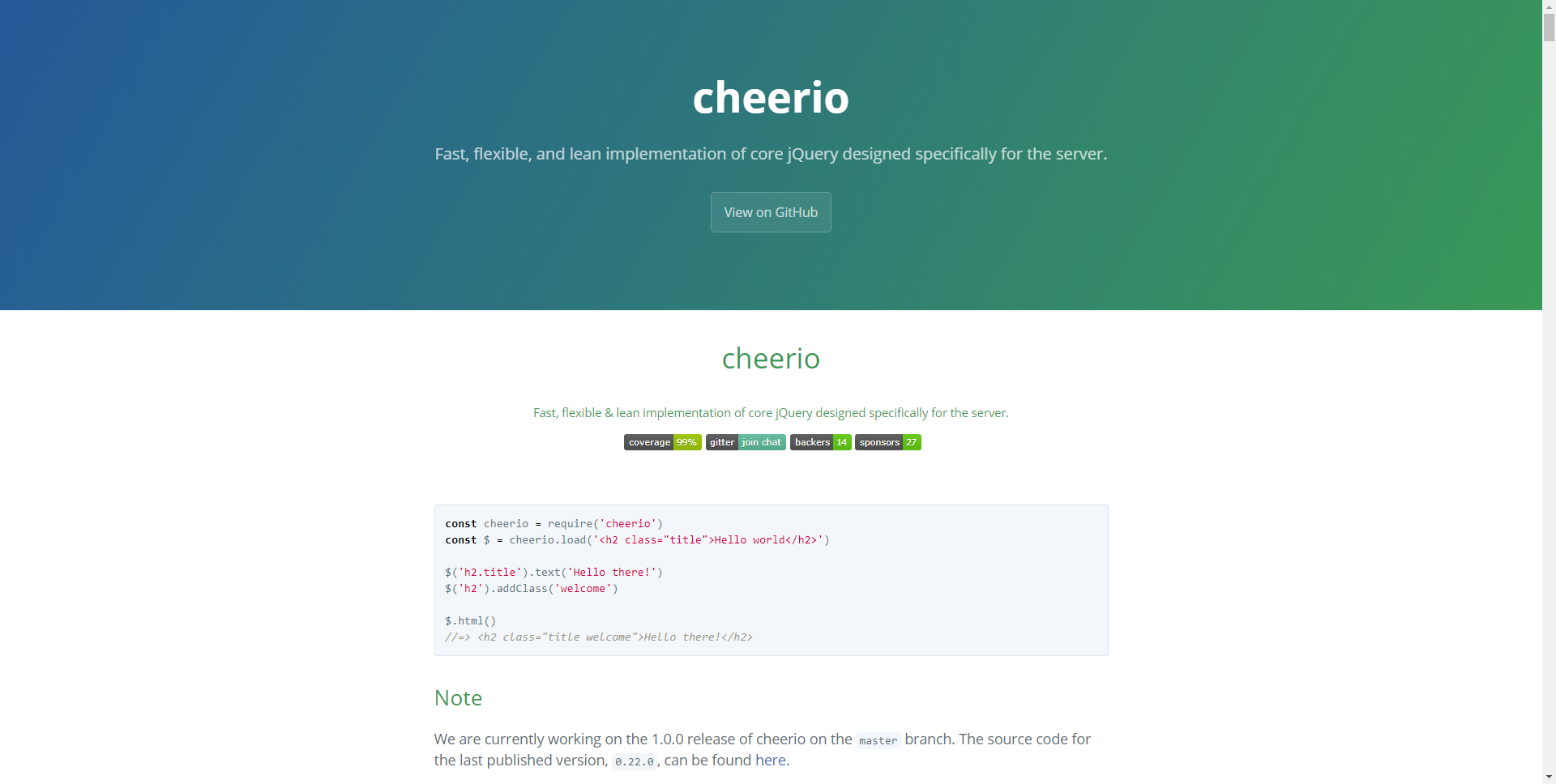

6.Cheerio

CheerioはHTMLを簡単に解析するNodeJS開発者である。 jQueryに精通している人は、利用可能な最高のjavascript Webスクレイピング構文をすぐに評価するでしょう。CheerioにはjQueryに似たAPIが用意されているため、jQueryに精通している開発者はすぐにCheerioを使用してHTMLを解析できます。 非常に高速で、テキスト、html、クラス、idなどを抽出するための多くの便利なメソッドを提供します。

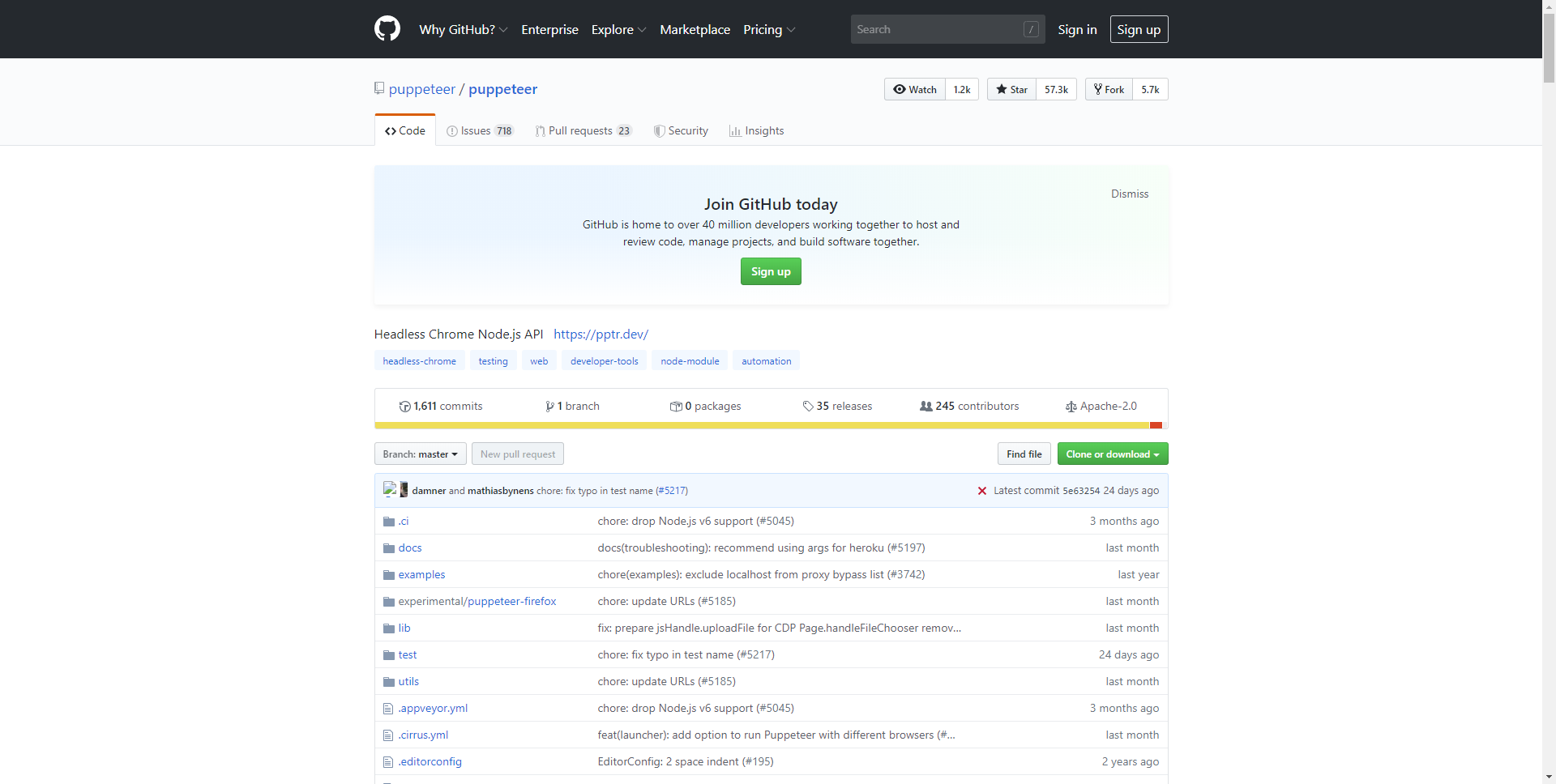

7.Puppeteer

Puppeteerは、スクレイピングアクティビティを非常にきめ細かく制御したいNodeJS開発者向けのヘッドレスChrome APIです。オープンソースツールとして、Puppeteerは完全に無料です。Google Chromeチーム自身によって積極的に開発および支援されています。デフォルトのヘッドレスブラウザ自動化ツールとして、SeleniumとPhantomJSをすぐに置き換えています。

8.Data Miner

必要なデータ、配置先などをユーザーに伝えるスクレイピングツールです。DataMinerは、レシピと呼ばれるものを処理します。 レシピは、ツールが何を削って何を入れるべきかを知るために使用する指示です。

任意のWebサイトからデータをスクレイピングし、Microsoft ExcelまたはGoogleスプレッドシートにインポートします。 Zoominfo、Zillow、Yellow Pages、Yelpなどに適応します。

9.Scraping-Bot.io

Scraping-Bot.ioは、URLからデータを取得する効率的なツールです。 画像、製品タイトル、製品価格、製品説明、在庫、配送費用、EAN、製品カテゴリなど、必要な情報をすべて収集できます。Googleでのランキングの確認や、 SEOを改善します。 ダッシュボードのライブテストを使用して、コーディングせずにテストします。

10.Datahut

Webサイトから構造化データを取得します。 これは、大量のデータが至る所に散らばっているeコマースWebサイトのデータ収集をかなり得意です。 このWebスクレイピングプラットフォームをユニークにする要因は、コーディング、サーバー、または高価なソフトウェアを必要としないことです。

1.ScrapeStorm

ScrapeStormとは、強い機能を持つ、プログラミングが必要なく、使いやすく人工知能Webスクレイピングツールです。違う基盤のユーザーに二つのスクレイピングモードを提供し、1-Clickで99%のWebスクレイピングを満たします。ScrapeStormにより、大量のWebデータを素早く正確的に取得できます。手動でデータ抽出が直面するさまざまな問題を完全に解決し、情報取得のコストを削減し、作業効率を向上させます。

2.VisualScraper

VisualScraperは、Webから情報を収集するために使用するWebスクレイピングツールです。 このソフトウェアは、複数のWebページからデータを抽出し、リアルタイムで結果を取得するのに役立ちます。 さらに、CSV、XML、JSON、SQLなどのさまざまな形式でエクスポートできます。月額49ドルから10万ページ以上のページにアクセスできるプレミアムプランに加えて無料で提供されます。 Parsehubと同様の無料のアプリケーションは、C ++パッケージが追加されたWindowsで利用できます。

3.Spinn3r

Spinn3rでは、ブログ、ニュース&ソーシャルメディアサイト、RSS&ATOMフィードからデータ全体を取得できます。インデックス作成作業の95%を管理するfirehouse APIとともに配布されます。 高度なスパム保護を提供します。これにより、スパムや不適切な言語の使用が削除され、データの安全性が向上します。Spinn3rは、Googleに似たコンテンツのインデックスを作成し、抽出したデータをJSONファイルに保存します。

4.Scraper API

Scraper APIツールは、プロキシ、ブラウザ、CAPTCHAの管理に役立ちます。 これにより、簡単なAPI呼び出しでWebページからHTMLを取得できます。 APIキーとURLを使用してAPIエンドポイントにGETリクエストを送信するだけでよいため、統合は簡単です。

5.ScrapeSimple

ScrapeSimpleは、カスタムスクレーパーを作成したい人に最適なサービスです。 Webスクレイピングは、必要なデータの種類に関する指示をフォームに入力するだけで簡単に作成できます。

ScrapeSimpleは、顧客向けのカスタムWebスクレーパーを構築および管理する完全に管理されたサービスで、その名の通りに機能します。 どのサイトからどのような情報が必要かを伝えるだけで、カスタムWebスクレイパーを設計して、CSV形式で定期的に(毎日、毎週、毎月など)情報を受信トレイに直接配信します。

6.Cheerio

CheerioはHTMLを簡単に解析するNodeJS開発者である。 jQueryに精通している人は、利用可能な最高のjavascript Webスクレイピング構文をすぐに評価するでしょう。CheerioにはjQueryに似たAPIが用意されているため、jQueryに精通している開発者はすぐにCheerioを使用してHTMLを解析できます。 非常に高速で、テキスト、html、クラス、idなどを抽出するための多くの便利なメソッドを提供します。

7.Puppeteer

Puppeteerは、スクレイピングアクティビティを非常にきめ細かく制御したいNodeJS開発者向けのヘッドレスChrome APIです。オープンソースツールとして、Puppeteerは完全に無料です。Google Chromeチーム自身によって積極的に開発および支援されています。デフォルトのヘッドレスブラウザ自動化ツールとして、SeleniumとPhantomJSをすぐに置き換えています。

8.Data Miner

必要なデータ、配置先などをユーザーに伝えるスクレイピングツールです。DataMinerは、レシピと呼ばれるものを処理します。 レシピは、ツールが何を削って何を入れるべきかを知るために使用する指示です。

任意のWebサイトからデータをスクレイピングし、Microsoft ExcelまたはGoogleスプレッドシートにインポートします。 Zoominfo、Zillow、Yellow Pages、Yelpなどに適応します。

9.Scraping-Bot.io

Scraping-Bot.ioは、URLからデータを取得する効率的なツールです。 画像、製品タイトル、製品価格、製品説明、在庫、配送費用、EAN、製品カテゴリなど、必要な情報をすべて収集できます。Googleでのランキングの確認や、 SEOを改善します。 ダッシュボードのライブテストを使用して、コーディングせずにテストします。

10.Datahut

Webサイトから構造化データを取得します。 これは、大量のデータが至る所に散らばっているeコマースWebサイトのデータ収集をかなり得意です。 このWebスクレイピングプラットフォームをユニークにする要因は、コーディング、サーバー、または高価なソフトウェアを必要としないことです。