◆NVIDIA Jetson Nano に Intel Realsense D435i を接続して、Isaac でリモートする手順

1.準備

■■■Remote

●CPU: NVIDIA Jetson Nano開発キット

●SD: SDSQXCY-128G-GN6MA

●AC/DC: LTE36ES-S1-301(DC5V 6.2A)

●FAN: PEAD14028BH(Max:20000rpm)

●WiFi: intel 8265NGW

■■■Depth Camera

●Camera: Intel Realsense D435i

■■■Master PC

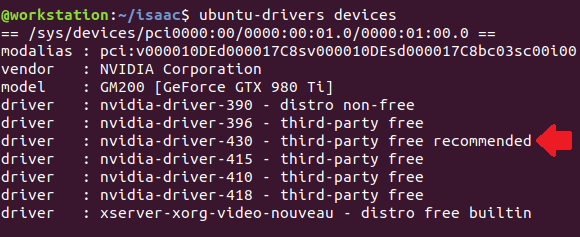

●OS: ubuntu 18.04 LTS

●Tool: NVIDIA Isaac SDK

2.デスクトップに Intel Realsense SDK 2.0 導入

参考記事:IntelRealSense/librealsense ※最新の情報を必ず確認する事

# サーバー公開鍵の登録

~$ sudo apt-key adv --keyserver keys.gnupg.net --recv-key C8B3A55A6F3EFCDE || sudo

apt-key adv --keyserver hkp://keyserver.ubuntu.com:80 --recv-key

C8B3A55A6F3EFCDE

# リポジトリ登録

~$ sudo add-apt-repository "deb http://realsense-hw-public.s3.amazonaws.com/Debian/apt-repo bionic main" -u

# ライブラリインストール

~$ sudo apt-get install librealsense2-dkms

~$ sudo apt-get install librealsense2-utils

# デバッグパッケージインストール

~$ sudo apt-get install librealsense2-dev

~$ sudo apt-get install librealsense2-dbg

# 確認

~$ realsense-viewer

~$ modinfo uvcvideo | grep "version:"

~$ sudo apt-get update

~$ sudo apt-get upgrade

3.Intel Realsense ファームウェアアップ

参考記事:How to install Firmware DFU on Ubuntu 18.04 · Issue #2884 · IntelRealSense/librealsense

# intel-realsense-dfu ツールインストール

~$ echo 'deb http://realsense-hw-public.s3.amazonaws.com/Debian/apt-repo xenial main' | sudo tee /etc/apt/sources.list.d/realsense-public.list

~$ sudo apt-key adv--keyserverkeys.gnupg.net --recv-key 6F3EFCDE

~$ sudo apt-get update

~$ sudo apt-get install intel-realsense-dfu*

# ダウンロード インテル® RealSense™センス™D400製品ファミリの最新ファームウェア ここから最新バージョンをダウンロード

# バージョン: 5.11.6.250 (最新)日付: 2019/06/04

# デスクトップの ~/isaac へD400_Series_Production_FW_5_11_6_250.zipをコピーして、Signed_Image_UVC_5_11_6_250.bin を取り出す

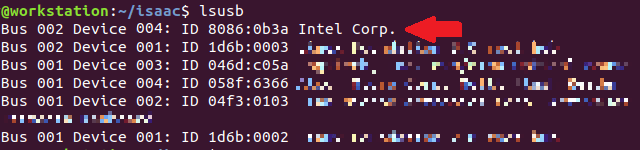

# D435iがデスクトップに接続されているポートを確認

~$ lsusb

■■■Remote

●CPU: NVIDIA Jetson Nano開発キット

●SD: SDSQXCY-128G-GN6MA

●AC/DC: LTE36ES-S1-301(DC5V 6.2A)

●FAN: PEAD14028BH(Max:20000rpm)

●WiFi: intel 8265NGW

■■■Depth Camera

●Camera: Intel Realsense D435i

■■■Master PC

●OS: ubuntu 18.04 LTS

●Tool: NVIDIA Isaac SDK

2.デスクトップに Intel Realsense SDK 2.0 導入

参考記事:IntelRealSense/librealsense ※最新の情報を必ず確認する事

# サーバー公開鍵の登録

~$ sudo apt-key adv --keyserver keys.gnupg.net --recv-key C8B3A55A6F3EFCDE || sudo

apt-key adv --keyserver hkp://keyserver.ubuntu.com:80 --recv-key

C8B3A55A6F3EFCDE

# リポジトリ登録

~$ sudo add-apt-repository "deb http://realsense-hw-public.s3.amazonaws.com/Debian/apt-repo bionic main" -u

# ライブラリインストール

~$ sudo apt-get install librealsense2-dkms

~$ sudo apt-get install librealsense2-utils

# デバッグパッケージインストール

~$ sudo apt-get install librealsense2-dev

~$ sudo apt-get install librealsense2-dbg

# 確認

~$ realsense-viewer

~$ modinfo uvcvideo | grep "version:"

~$ sudo apt-get update

~$ sudo apt-get upgrade

3.Intel Realsense ファームウェアアップ

参考記事:How to install Firmware DFU on Ubuntu 18.04 · Issue #2884 · IntelRealSense/librealsense

# intel-realsense-dfu ツールインストール

~$ echo 'deb http://realsense-hw-public.s3.amazonaws.com/Debian/apt-repo xenial main' | sudo tee /etc/apt/sources.list.d/realsense-public.list

~$ sudo apt-key adv--keyserverkeys.gnupg.net --recv-key 6F3EFCDE

~$ sudo apt-get update

~$ sudo apt-get install intel-realsense-dfu*

# ダウンロード インテル® RealSense™センス™D400製品ファミリの最新ファームウェア ここから最新バージョンをダウンロード

# バージョン: 5.11.6.250 (最新)日付: 2019/06/04

# デスクトップの ~/isaac へD400_Series_Production_FW_5_11_6_250.zipをコピーして、Signed_Image_UVC_5_11_6_250.bin を取り出す

# D435iがデスクトップに接続されているポートを確認

~$ lsusb

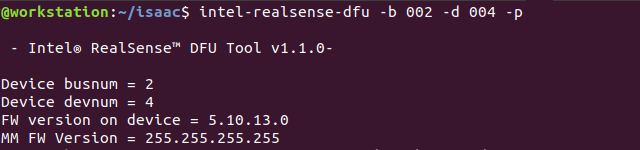

# Bus 002 Device 004 の場合のファームウェアバージョン確認

~$ intel-realsense-dfu -b 002 -d 004 -p

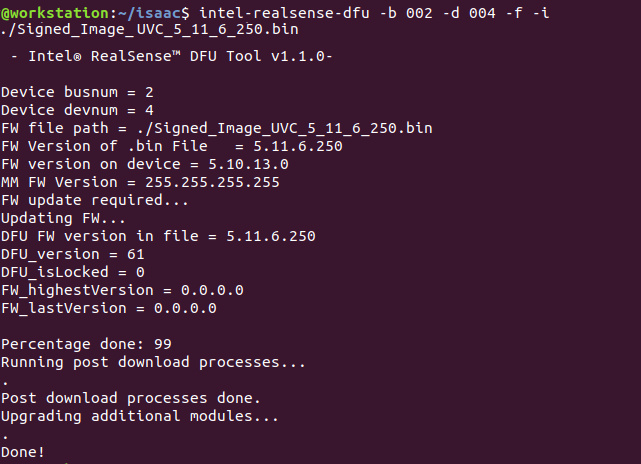

# ファームウェアバージョンが 5.11.6.250 未満の場合

~$ cd ~/isaac

~/isaac$ intel-realsense-dfu -b 002 -d 004 -f -i ./Signed_Image_UVC_5_11_6_250.bin

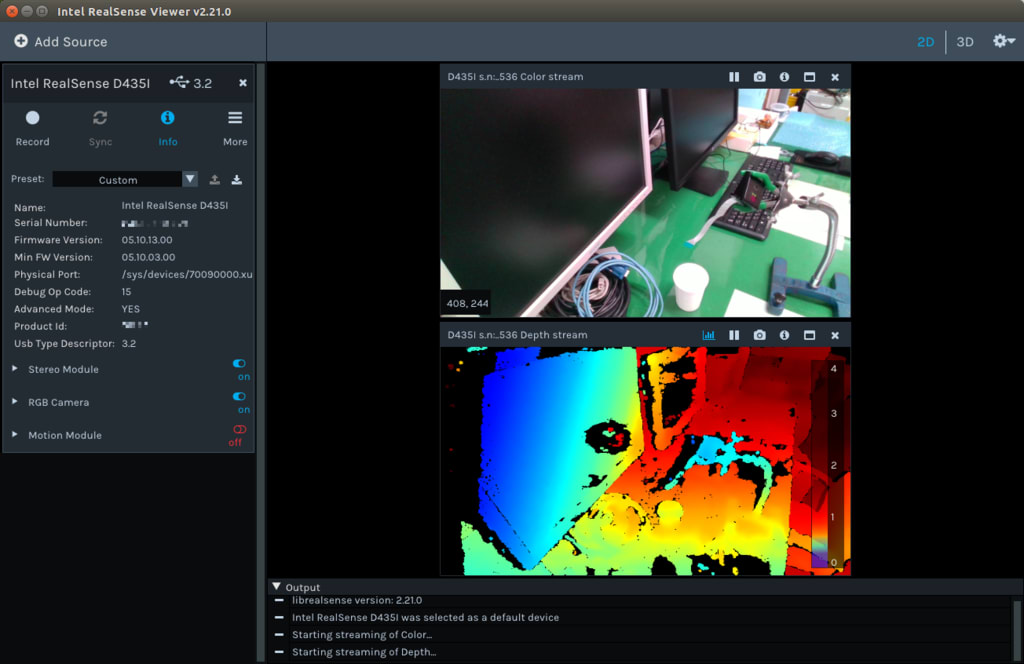

# 動作確認

~/isaac$ realsense-viewer

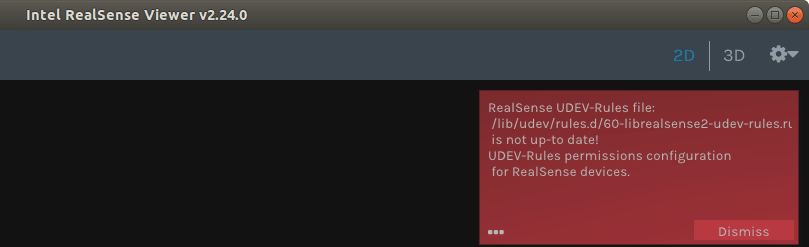

# UDEV rules issue after updating to 2.24 · Issue #4350 · IntelRealSense/librealsense この記事の問題がある

# ビューアーを閉じて、Realsense D435i を Jetson nano へ接続する

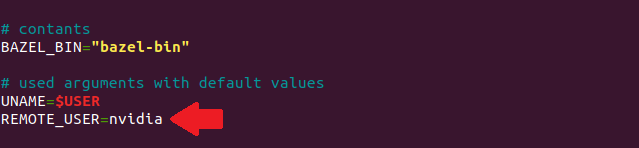

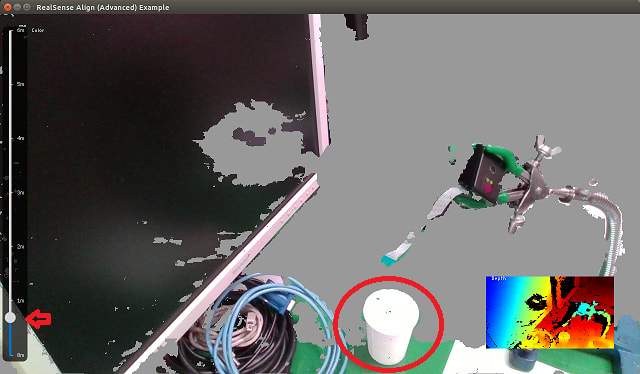

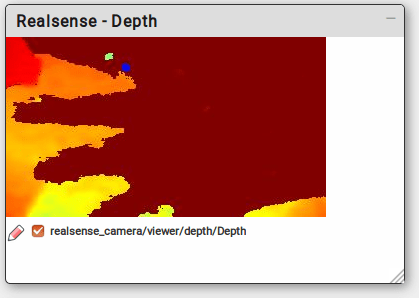

4.サンプルrealsense_cameraの実行

# <jetson_nano_ip>: 192.168.0.119

# <jetson_nano_name>: ai の場合

# デスクトップでサンプルビルド

~/isaac$ bazel build //apps/samples/realsense_camera

# Jetson nano と D435i がUSB接続されている事(デスクトップから外して)

# <jetson_nano_ip>: 192.168.0.119

# <jetson_nano_name>: ai の場合

# デスクトップでサンプルビルド

~/isaac$ bazel build //apps/samples/realsense_camera

# Jetson nano と D435i がUSB接続されている事(デスクトップから外して)

# デスクトップとJetson nano がLAN接続している事

~/isaac$ ./engine/build/deploy.sh -d jetpack42 -h 192.168.0.119 -p

//apps/samples/realsense_camera:realsense_camera-pkg

#jetson nanoへssh接続

~/isaac$ ssh ai@192.168.0.119

# Jetson nano を最大パフォーマンス動作

ai@jetson:~$ sudo /usr/bin/jetson_clocks

# デスクトップのユーザー名が userの場合

# realsense_camera を実行

ai@jetson:~$ cd deploy/user/realsense_camera-pkg/

ai@jetson:~/deploy/user/realsense_camera-pkg$ ./apps/samples/realsense_camera/realsense_camera

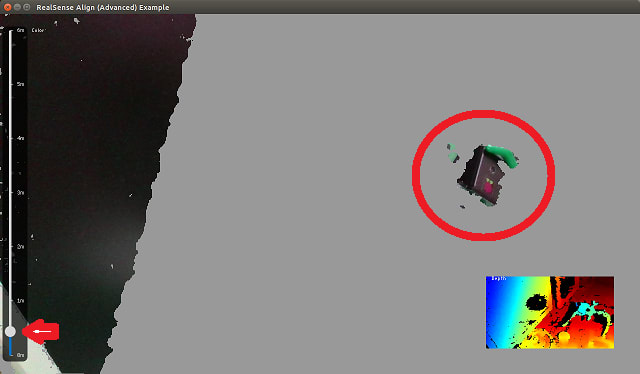

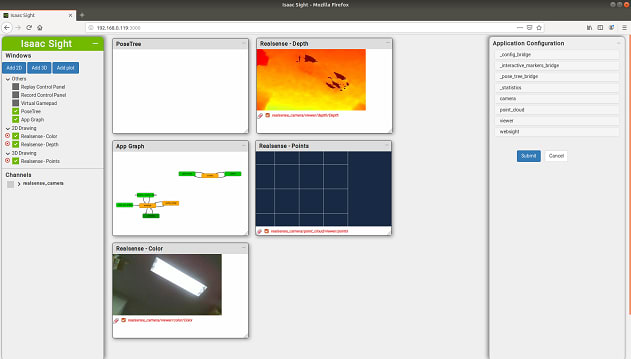

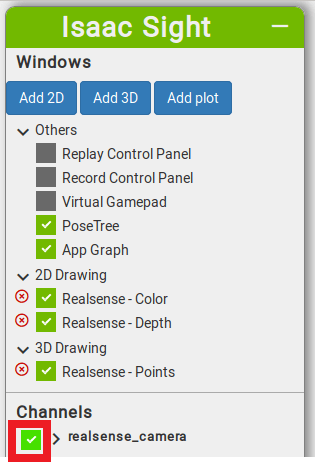

# デスクトップのブラウザで確認

http://192.168.0.119:3000/

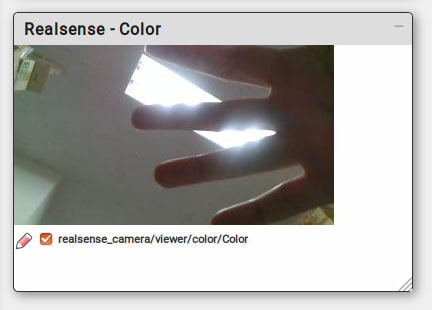

# カメラをチェック

ライブビューが映し出される

━以上━