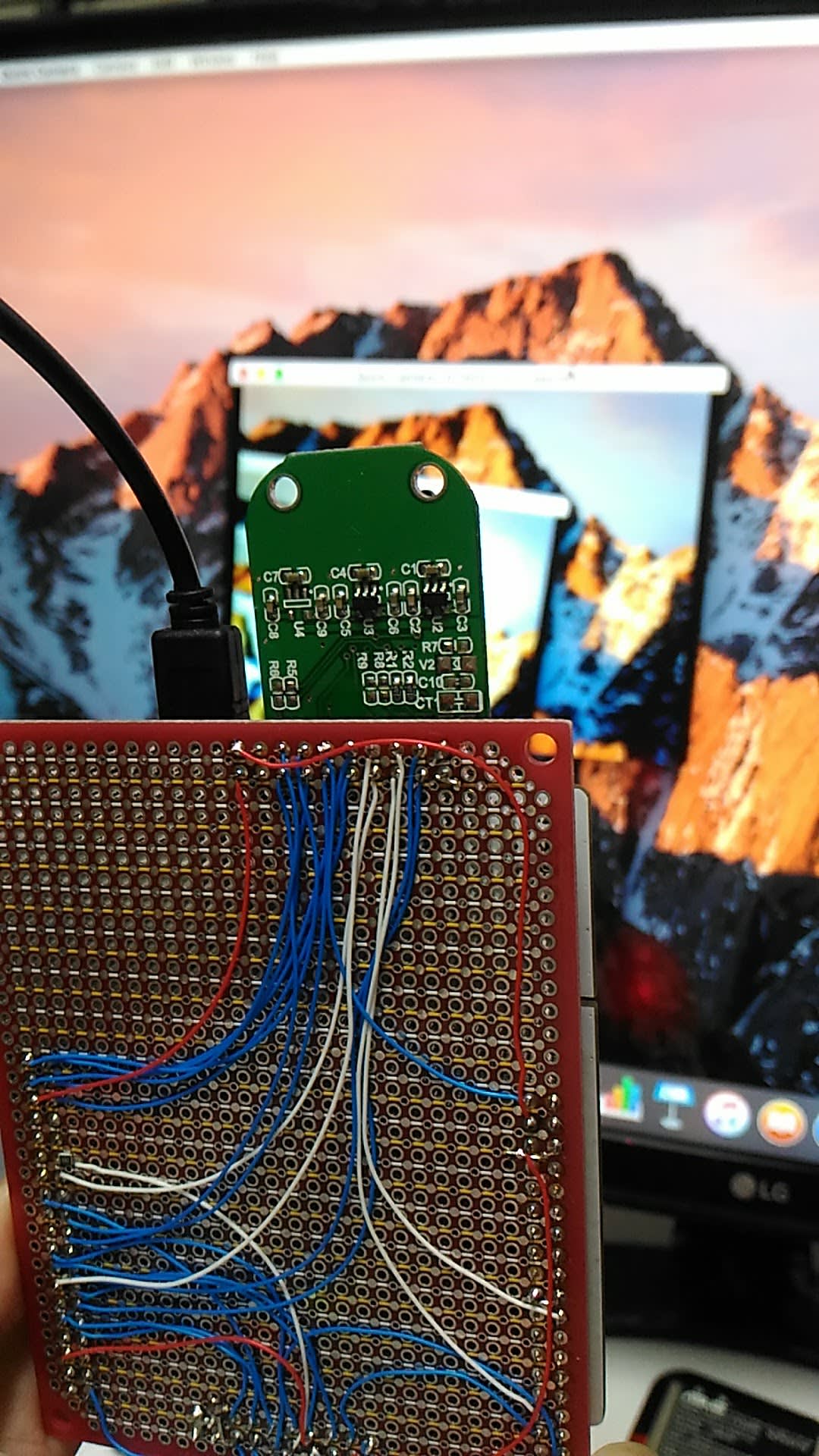

BM20の動作確認のために発注しておいた実験用基板が届きました。今回はElecrowを使って青色基板を指定してみました。5枚で$4.9のコースで、送料込みでも$9.88でしたが、実際には7枚の基板が送られてきました。

基板の回路はBM20の評価ボードであるBM-20-EVBを真似ていますが、まずは必要最低限の動作確認ができればいいので、コネクタや使用部品数を減らして基板サイズも小さくしてあります。

早速、手持ちの部品を載せてみました。残りがあるつもりだったタクトスイッチがひとつだけしか見つからなかったので、これを電源ON/OFFも兼ねるMFBボタンとして使うことにします。残る5つのスイッチで音量上下や Play/Pause, Fwd/Rev操作ができるのですが、また後で部品箱を漁ってみることにしましょう。ちなみにMFBというのは

続いて、実際に動作を確認するために、電源とスピーカーを接続。 100均のアンプ無しスピーカーなので、音量は出ませんが動作確認にはこれでも十分です。もちろん、イヤホンをつなげれば十分な音量で鳴ります。

電源はFT232ボードを介してUSBからの5VをBM20のADP_INに供給しています。BM20にはLiPo電池の充電機能も備わっており、ヘッダピンには電池をつなぐBAT_IN端子も出してありますが、電池をつながなくても動いてくれるので、オープンのままで動作確認を始めることにします。

基板の回路はBM20の評価ボードであるBM-20-EVBを真似ていますが、まずは必要最低限の動作確認ができればいいので、コネクタや使用部品数を減らして基板サイズも小さくしてあります。

- 電源の供給とホストとの接続はピンヘッダ経由。

- ジャックは音声出力用にひとつだけ用意。マイクは基板上に載せてしまうことに。

- ライン入力は使わないことにして、代わりにブザー用のパターンを用意。

- NFCタグは使わないことにして、関連部品を省略。

- DISP SWには秋月で売られていたハーフピッチの4Pを使用。実際には3Pしか使いません。

- 電源ON/OFFにはMFBだけを使うことにして、スライドSW関連部品を省略。

早速、手持ちの部品を載せてみました。残りがあるつもりだったタクトスイッチがひとつだけしか見つからなかったので、これを電源ON/OFFも兼ねるMFBボタンとして使うことにします。残る5つのスイッチで音量上下や Play/Pause, Fwd/Rev操作ができるのですが、また後で部品箱を漁ってみることにしましょう。ちなみにMFBというのは

Multi Function Buttonの略のようです。

続いて、実際に動作を確認するために、電源とスピーカーを接続。 100均のアンプ無しスピーカーなので、音量は出ませんが動作確認にはこれでも十分です。もちろん、イヤホンをつなげれば十分な音量で鳴ります。

電源はFT232ボードを介してUSBからの5VをBM20のADP_INに供給しています。BM20にはLiPo電池の充電機能も備わっており、ヘッダピンには電池をつなぐBAT_IN端子も出してありますが、電池をつながなくても動いてくれるので、オープンのままで動作確認を始めることにします。