AI兵器vs AI兵器の戦争は人知を超える(キッシンジャー&エリック・シュミット)

ヘンリー・キッシンジャー(元米国務長官),エリック・シュミット(グーグル元CEO),ダニエル・ハッテンロッカー(マサチューセッツ工科大学〔MIT〕学部長)

Newsweek より 211124

自律編隊飛行プログラムで飛ぶNASAの実験機 NASA

<「核より恐ろしい」――既に囲碁やチェスで人間を置き去りにしたAIの知性は、戦争をここまで残酷にする。ヘンリー・キッシンジャー元国務長官とエリック・シュミット元グーグルCEOらの新著から>

⚫︎人工知能(AI)が戦場に出たらどうなるか。もう人間の出番はなくなるのか。

この究極の問いに、アメリカを代表する戦略家であるヘンリー・キッシンジャー(元国務長官)とAI最前線に詳しいエリック・シュミット(元グーグルCEO)、そしてMITシュワルツマン・カレッジ・オブ・コンピューティング学部長のダニエル・ハッテンロッカーが共著『AIの時代、そして人類の未来 (The Age of AI: AndOur Human Future)』で挑み、やはり人間の関与が不可欠との結論を導いた。

以下はその要約。

◇ ◇ ◇

人類の歴史を通じて、国家の政治的影響力は軍事力、すなわち他国の社会に損害を与える能力と結び付いてきた。

だが軍事力に基づく均衡は一定ではない。その均衡が依拠するコンセンサスは、何をもって国力・軍事力・影響力とするかだが、均衡を決定づける力の本質について当事者の意見が分かれると、誤解によって紛争が起きかねない。

近年、コンセンサスの形成を難しくしているのがサイバー兵器の出現だ。こうした技術は民生部門でも用いられるため、何をもって兵器と呼ぶかの定義も定まらない。サイバー兵器の保有やその能力を認めない国が、そうした技術で軍事力を行使、あるいは増強している例もある。

何をもって紛争と呼ぶか、敵が誰で、敵の戦闘能力はどれくらいかなど、伝統的な戦略上の常識が、デジタルの世界では通用しない。

現代が抱える大きな矛盾は、社会のデジタル化が進めば進むほど、脆弱性が増す点にある。通信網や発電所、電力網、金融市場、大学、病院、公共交通機関、そして民主的な政治の仕組みすら、多かれ少なかれデジタルに依存するようになっているが、こうしたシステムは不正操作が行われやすく、攻撃にも弱い。

国家であれテロ組織であれ、サイバー攻撃の仕掛け人は自らの能力や活動の全容を明らかにしない。だから新たな能力が開発されても、戦略も行動原理も見えてこない。

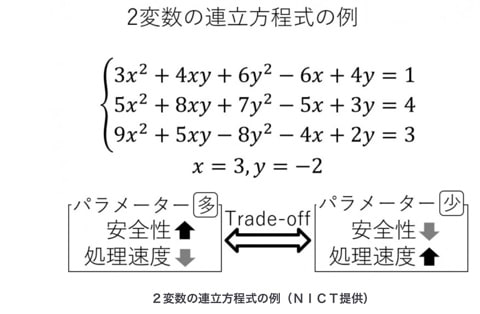

ただでさえ複雑なサイバー兵器にAIが本格導入されれば、戦略決定はますます複雑になり、人間の意図はおろか理解さえも及ばなくなる危険性を秘めている。

昔から戦争は不確かで予測不能なものだ。だが戦争を導いてきた論理もさまざまな限界も、これまでは人間が生んだものだった。

しかしAIのアルゴリズムは人間の能力をはるかに超えて複雑なパターンを特定し、あるいは予測できる。だからAIは人間の手に負えない問題を解決し、戦略を立てることができる。

囲碁やチェスの世界では、グーグル傘下のディープマインドが開発したAIプログラムが、専門家も驚くような戦略で人間に勝利したが、安全保障の分野でも同じことが起き得る。その可能性は十分にある。

軍隊や治安当局がAIを訓練、またはAIと連携して予想外の見識や影響力を獲得すれば、驚くと同時に不安な事態にもなるだろう。

⚫︎AI兵器を使いこなせるか

AIがデータを学習して環境に適応し、進化すれば、設計や操作もAI任せの兵器を開発できる。だがそれを使う国は、その兵器が実際にどのような動きをし、どのくらい強力なのかを正確に把握できないかもしれない。

人間には認識できない、あるいは認識に時間がかかる状況もAI兵器なら直ちに把握し、場合によっては人間の思考速度や能力を超えて学習・進化し得る。

防衛的な活動では、現にいくつかのレベルでAIの能力が活用されており、遠からず不可欠なものになるだろう。既にAIが操縦する戦闘機は、シミュレーションによる空中戦で人間のパイロットを凌駕する能力を示している。

従来の紛争では、敵の心理を読み取って行動することが重要だった。だがAIに必要なのは指示と目標だけで、士気も疑念も関係ない。

一方、仮に2つのAI兵器システムが対峙した場合、いずれのシステムも互いの能力を正確には知らないから、それぞれの相互作用が生み出す結果や損害を正確には予測できない。そうなると紛争は一段とエスカレートし、何よりも予測不能な展開を見せる可能性が高い。

ILLUSTRATION BY BRANDON LAUFENBERG/GETTY IMAGES, IHOR SVETIUKHA/GETTY IMAGES

だが最も予測し難いのは、AIと人間のインテリジェンスが交錯する場面で何が起きるかだろう。

歴史を顧みれば、国家は戦闘計画の策定に当たり、敵国の行動原理や戦術、そして心理を、たとえ不完全であっても理解していた。だからこそ対抗する戦略や戦術を考案でき、適切な軍事的示威行動(境界線に近づく航空機や艦艇のインターセプトなど)で警告を送ることもできた。

しかし軍隊がAIを計画立案や標的の識別に、いや偵察や戦闘の積極的支援に導入しただけでも、在来のコンセプトはたちまち怪しくなる。在来の方法論や戦術に通じていない別なインテリジェンスとの対話や解釈が必要になるからだ。

そもそもAI(に支援された)兵器や防衛システムへの移行は、およそ人間とは異質な経験的パラダイムで動く膨大な分析能力に一定程度まで依存し、最も極端な場合には完全に判断を委ねることを意味する。そうした依存は未知の、あるいはよく理解されていないリスクを招く。

それ故、人間のオペレーターが介在し、致死的な効果を及ぼしかねないAIの行動を監視し、制御しなければならない。それでも全てのエラーを防ぐことはできないだろうが、少なくとも倫理や責任の問題には対処できる。

より深刻なのは哲学的な問題かもしれない。もしも戦略レベルの決定が人間には理解できないがAIならアクセスできる概念的・分析的領域で下されるとしたら、その戦略の決定プロセスも究極的な影響も人間には知り得ないことになる。

敵も独自のAIシステムを使っている可能性があり、そうした敵の能力や意図を理解し、迅速に対応するにはAIによる最も深いレベルのパターン認識が不可欠と考えるなら、重要な決定を機械に委ねる場面が増えることは避けられない。

どこまでを機械に委ね、それに伴うリスクと結果をどこまで受け入れるかについては、国によって許容範囲が異なるだろう。しかし主要国は危機が訪れる前に、こうした進化のもたらす戦略的・原理的・道徳的な影響についての対話を始めるべきだ。

危機が起きてからでは取り返しがつかない。こうしたリスクを限定する国際的な努力が欠かせない。

その際にはAIのダイナミックな性質も考慮しなければならない。ひとたび現実世界に放たれれば、AIを駆使したサイバー兵器は当初の想定をはるかに超えた適応と学習を重ねる可能性がある。こうした兵器の能力が開発者の意図を超えて変化していけば、戦闘の抑止や拡大に関する従来の計算は成り立たない。

それ故、AIが実行できる活動の範囲は、設計段階でも実戦配備の段階でも事前に設定し、人間がAIを監視し、おかしな行動を始めたらシステムを停止あるいは修正できるようにしておく必要がある。

想定外の壊滅的な事態を避けるためには、そうした制御機能を敵も味方も備えておく必要がある。

AIやサイバー兵器の能力を具体的にどこまで制限するかは難しい。こうした兵器の拡散を阻止するのも難しい。

大国が開発し、使用した能力は、たやすくテロリストや犯罪者の手に渡り得る。また核兵器を持たず、通常兵器の戦力も限られている小国でさえ、最先端のAIやサイバー兵器に積極投資すれば等身大以上の影響力を持てる。

国家(軍隊)が非致死的なタスクをAIに(場合によってはAIを運用する民間企業に)委ねる動きは止められない。例えばサイバー空間への侵入を検知し、阻止する防衛機能などだ。

⚫︎人間の監督と介入は必須

デジタル化し、高度にネットワーク化された社会の「攻撃対象領域」は広すぎて、人間のオペレーターだけでは対応できない。

人々の暮らしがどんどんオンラインにシフトし、経済のデジタル化も続く今の時代には、たった1人の悪者でも、AIサイバー兵器を駆使すれば世の中を大混乱させることができる。国家も企業も、そして個人も、そのような事態を防ぐために投資すべきだ。

安全を守る最も極端な方法はネットワークを遮断し、システムをオフラインにすることだ。国家にとってはそれが究極の防御かもしれない。

しかし、そこまで極端な措置を取れないなら、サイバー攻撃への防御もAIに委ねるしかない。なにしろサイバースペースは広大で、そこで実行し得る行動パターンはほとんど無限にある。それに対処できる有効な防御システムを構築できるのは、ごく一部の国だけだろう。

もっと厄介なのは、AIで自律的に動き、かつ殺傷能力を持つ兵器システムだ。ひとたび作動すると、人間の介入なしに標的を選択し、攻撃できるシステムなどが想定されるが、ここでも人間による監視とタイムリーな介入が不可欠だ。

自律型兵器システムには、その行動を人間が外部から監視する仕組みや、特定の行為に人間の承認を必要とする仕組みを設けられる。

だが確実に遵守され検証可能な相互合意によって制限を課さない限り、後者のような自律型兵器システムはいずれ、戦略や目的(国境防衛や限定的な反撃など)の全てを担い、人間の実質的関与なしに行動するようになるだろう。

これらの分野では、行動の監視と武力行使の指示に人間の判断が関与する仕組みが絶対に必要だ。

このような制限は一部の国家が採用するだけでは意味がない。先進的な技術を持つ諸国の政府は、強制力のある検証作業に裏付けられた相互抑制の課題に向き合わねばならない。

AIは先制攻撃や、早まった実力行使による紛争拡大のリスクを高める。敵が自律型兵器を開発することを恐れる国は、先制攻撃に走るかもしれない。意図せざる紛争の深刻化を防ぐには、軍拡競争も検証可能な制限の範囲内に限る必要がある。

交渉では、軍拡競争の緩和だけでなく、当事者が一般的な意味で互いの行為を理解していることを確認すべきだ。

ただし最も機密性の高い秘密は互いに公表しないだろうし,相互に完全に信頼することもあり得ない。だが冷戦時代の核軍縮交渉が示すように,理解の方法が全くないわけではない。

核兵器の時代を画することになったもろもろの軍縮協定(と、それに伴う対話や相互検証のメカニズム)は、決して歴史の必然ではなかった。それは人間の努力がもたらしたもの──互いの脅威を知るだけでなく、互いの責任にも気付いた人間がもたらしたものだ。

ヘンリー・キッシンジャー(元米国務長官)、エリック・シュミット(グーグル元CEO)、ダニエル・ハッテンロッカー(マサチューセッツ工科大学〔MIT〕学部長)

【話題の記事】 ドローンが「知性」を持ち始めた。止めるなら今だ

米軍の新兵器は「サイボーグ兵士」、DARPAが開発中

Newsweek11月30日号(11月24日発売)は「AI戦争の時代」特集。人工知能を持つ「ターミネーター」が自ら敵を殺し始めた。PLUS ヘンリー・キッシンジャー「核より恐ろしいAI兵器」