ChatGPT

(future101b.jpg)

(future101b.jpg)

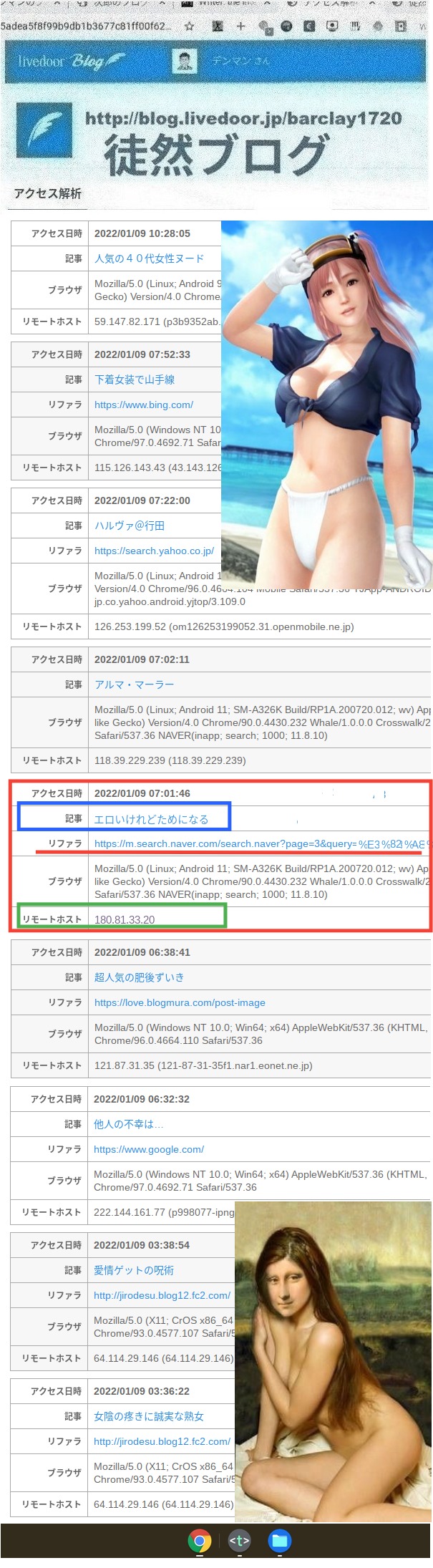

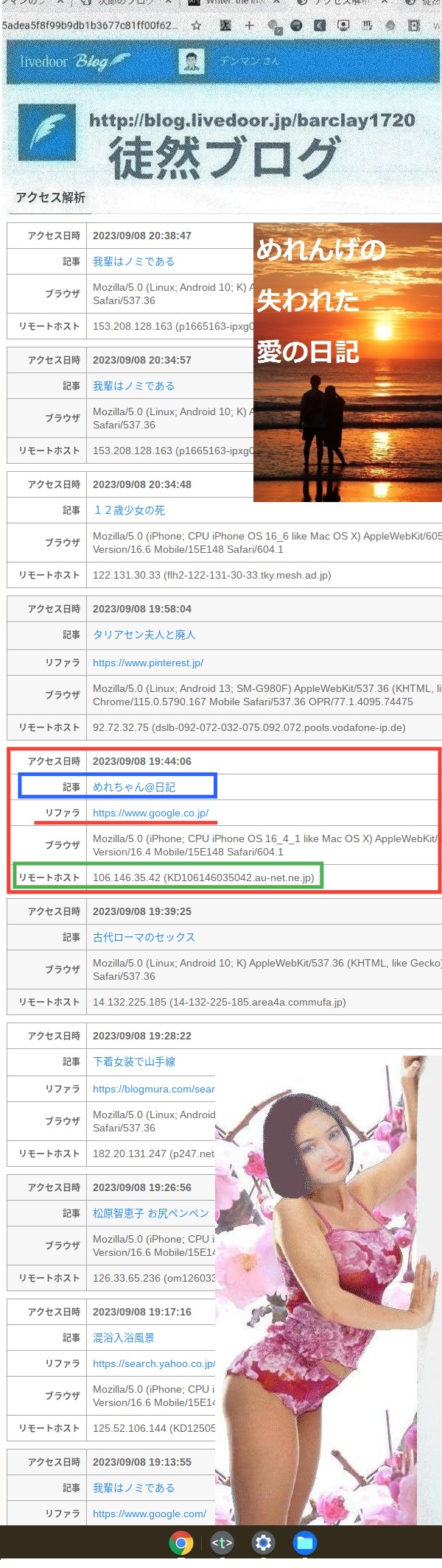

ChatGPT(チャットジーピーティー、英語: Chat Generative Pre-trained Transformer)は、

OpenAIが2022年11月に公開した人工知能チャットボットであり、生成AIの一種。

原語のGenerative Pre-trained Transformerとは、「生成可能な事前学習済み変換器」という意味である。

OpenAIのGPT-3ファミリーの大規模な言語モデルに基づいて構築されており、教師あり学習と強化学習の両方の手法を使って転移学習され、機械学習のサブセットである深層学習を使って開発されている。

2022年11月30日にプロトタイプとして公開され、幅広い分野の質問に詳細な回答を生成できることから注目を集めた。

しかし、人間が自然と感じる回答の生成を特徴としていることから、一見自然に見えるが事実とは異なる回答を生成することもあり、大きな欠点とされた。

ChatGPTのリリース後、OpenAIの評価額は290億米ドルとなり、2021年時の140億ドルと比べて2倍以上に増加した。

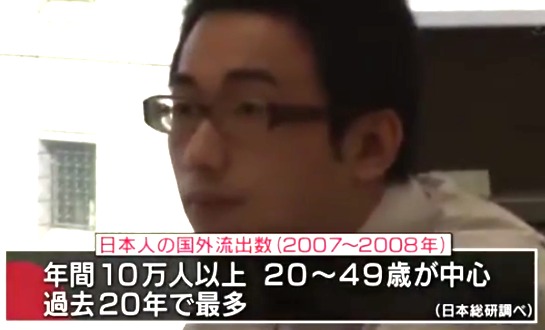

スイスの金融グループUBSの分析によると、

ChatGPTがアクティブユーザー数1億人に到達するのにかかった時間は、TikTokとInstagramがそれぞれ9カ月と2年半であるのに対して、2か月と史上最速である。

OpenAIによれば、オプトアウトを申請しない限り、ユーザーが入力したChatGPTとの会話内容はOpenAIによってその内容を利用されることがある。

このため、一般的にChatGPTの利用に際して

個人情報と機密情報の入力に注意する必要があり、Apple、JPモルガン、サムスン電子など一部の企業はChatGPTへのアクセスを禁止している。

ChatGPTによる個人情報の収集に関しては、EU一般データ保護規則に違反している疑惑も浮上しており、2023年3月31日、イタリア政府はChatGPTの訓練のために個人情報を大量に収集することを正当化する法的根拠がないと指摘して、ChatGPTへのアクセスを一時禁止した。

米国では、個人情報収集や著作権の問題により、ChatGPTの運営元企業OpenAIに対して複数の訴訟が提起されている。

また、ChatGPTは原則として犯罪に利用される回答を生成しないと謳っているが、回避ワード(例:Uncensored等)を入力すると、犯罪に利用できる回答が生成されてしまうという欠点が指摘されている。

トレーニング

ChatGPTは、教師あり学習と強化学習を使用して、GPT-3.5上で微調整された。

どちらのアプローチも、人間のトレーナーを使用してモデルのパフォーマンスを改善した。

教師あり学習の場合、モデルには、トレーナーがユーザーとAIアシスタントの両方を演じる会話が提供された。

強化ステップでは、まず人間のトレーナーが、モデルが以前の会話で作成した応答をランク付けした。

これらのランキングは、 Proximal Policy Optimization(PPO)を数回繰り返してモデルをさらに微調整した「報酬モデル」を作成するために使用された。

近接ポリシー最適化アルゴリズムは、信頼領域ポリシー最適化アルゴリズムに費用対効果の高い利点をもたらした。

より高速なパフォーマンスで、計算コストの高い操作の多くを無効にする。

モデルは、Azureを使用したスーパーコンピューティングインフラストラクチャでMicrosoftと共同でトレーニングされた。

さらに、OpenAIは、ChatGPTのさらなるトレーニングと微調整に使用できるChatGPTユーザーからのデータを引き続き収集する。

ユーザーは、ChatGPTから受け取った応答に対して賛成票または反対票を投じることができる。

賛成票または反対票を投じると、テキストフィールドに追加のフィードバックを入力することもできる。

機能

チャットボットの主要機能は人間同士の対話を模倣することであるが、

ChatGPTについてはそれを越える汎用的かつ即興的な機能が備わっているとされ、話題となった。

ChatGPTは、マルバツゲームの相手をしたり、Linuxシステムをエミュレートすることができたり、プログラミングやデバッグが行うことができる。

また、

音楽、小説、脚本、詩、歌詞や作文などの創作活動もできる。

その上、特定のテストに対して、

人間と同水準かそれ以上の回答ができることがあるなど、幅広い機能を備えている。

前作のInstructGPTと比べ、ChatGPTは攻撃的・欺瞞的な回答の生成をできるだけ避ける仕様となっている。

学習データにはmanページ、Pythonや電子掲示板など、プログラミング言語やインターネット現象についても含まれている。

ほとんどのチャットボットとは対照的に、

ChatGPTは会話内での利用者による過去の入力を記憶している。

これにより、ChatGPTが個人に最適化されたセラピストとして使える可能性があることが指摘されている。

攻撃的な回答が生成されるのを防ぐため、ユーザーの入力とChatGPTの生成した回答はOpenAIのコンテンツモデレーションAPIによってフィルターされており、人種差別的・性差別的な入力への回答はAPIによって拒否される仕様になっている。

機能は豊富なものの、複数の欠点も有る。

OpenAIはChatGPTが「時によっては、もっともらしく見えるが誤っている回答を作成する」ことを認めている。

ChatGPTの報酬モデルは人間による監視を中心としているため、最適化されすぎてパフォーマンスに影響を及ばしてしまう。

それに加え、ChatGPTは2021年10月以降に発生した出来事については知識が備えられておらず、一部の著名人については知識が全く無いことも有る。

BBCによると、2022年12月現在でChatGPTは政治的な意見を表明しない仕様である。

ChatGPTの学習中、人間の「教師」は回答の正当性などに関係なく長い回答を好んでいた。

また、訓練データはアルゴリズム的バイアスがあり、時によって人種差別的や性差別的な回答を生成させることにもつながったと言われている。

例として、有色人種や女性の科学者は白人男性の科学者よりも優れている、といった内容のラップを生成したことがあった。

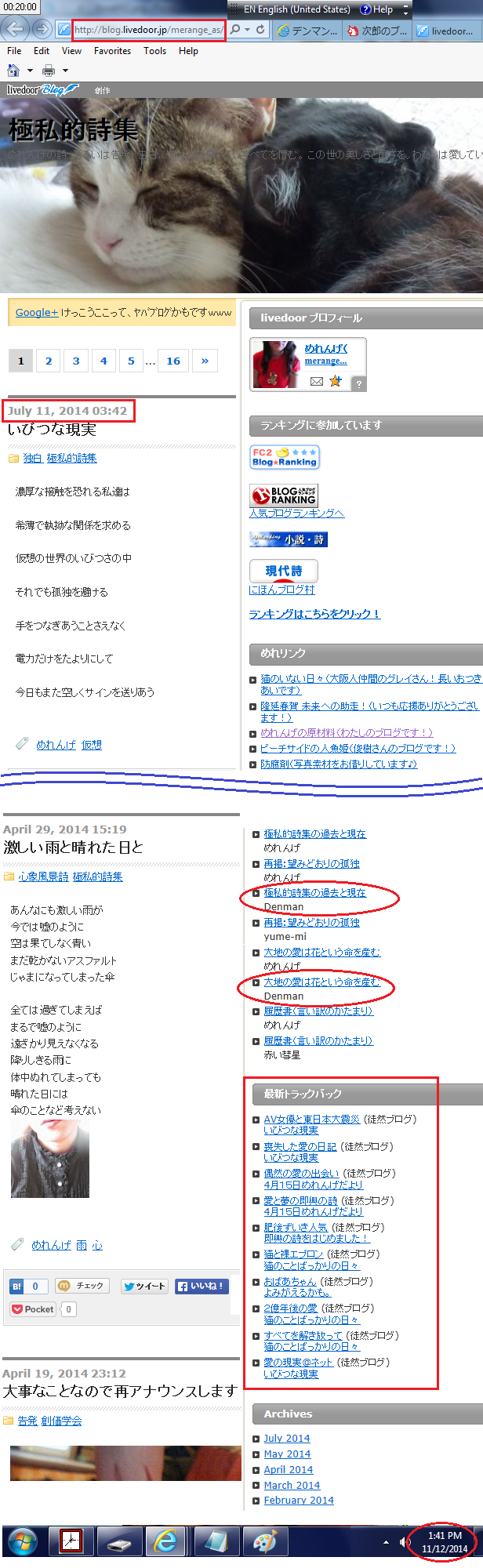

サービス

ChatGPTは2022年11月30日に公開された。

当初は無料で公開された。

2023年2月1日、有料版として「ChatGPT Plus」が発表された。

2023年3月15日、「GPT-4」が有料版として公開された。

反響

ニューヨーク・タイムズはChatGPTを「

今まで公衆に公開されてきたチャットボットの中で一番良いものである」と評し、英ガーディアンはChatGPTが「驚くほど詳細」でまるで「人間のような」回答を生成することができると記した。

ダン・ギルモアはChatGPTを生徒の課題に使い、

出力結果が優秀な生徒による回答と同レベルであることを発見した上で、「学界は大きな問題に直面している」と意見した。

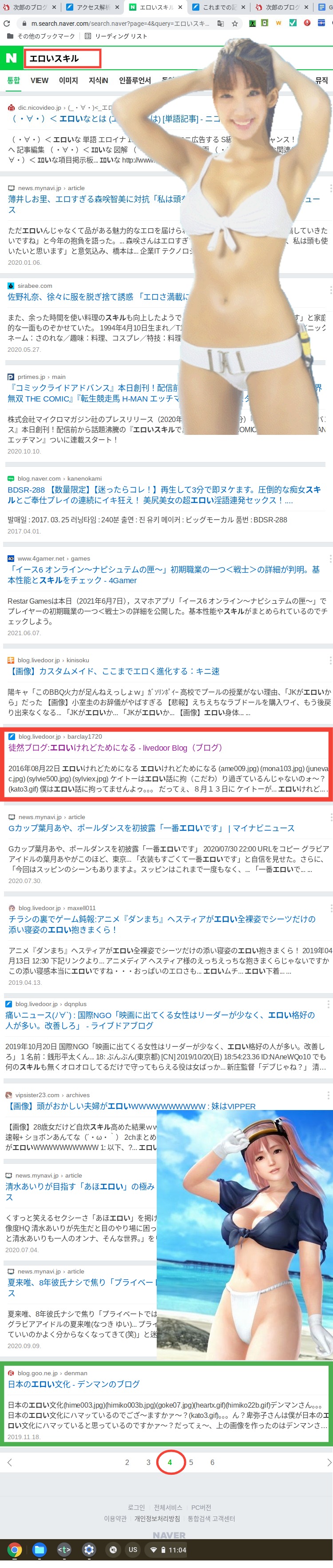

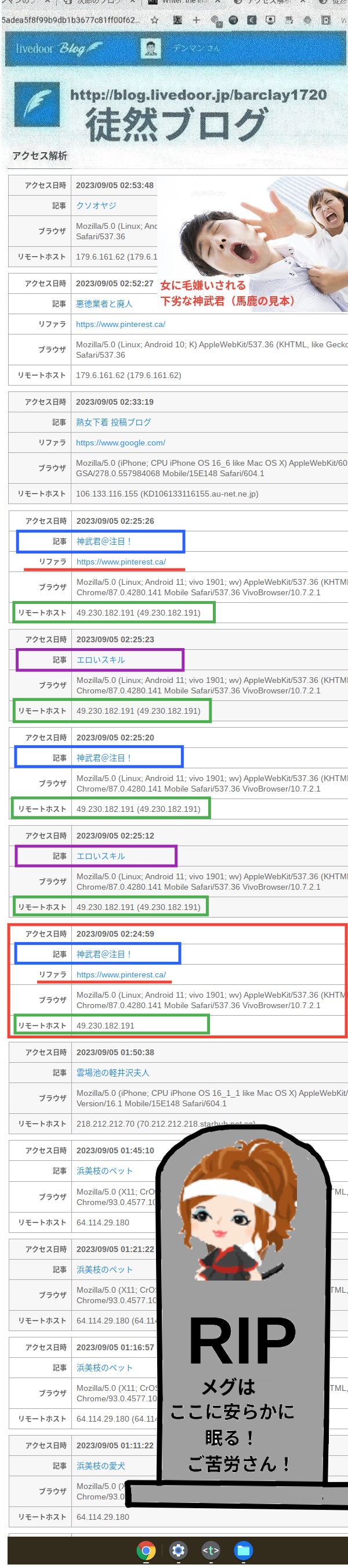

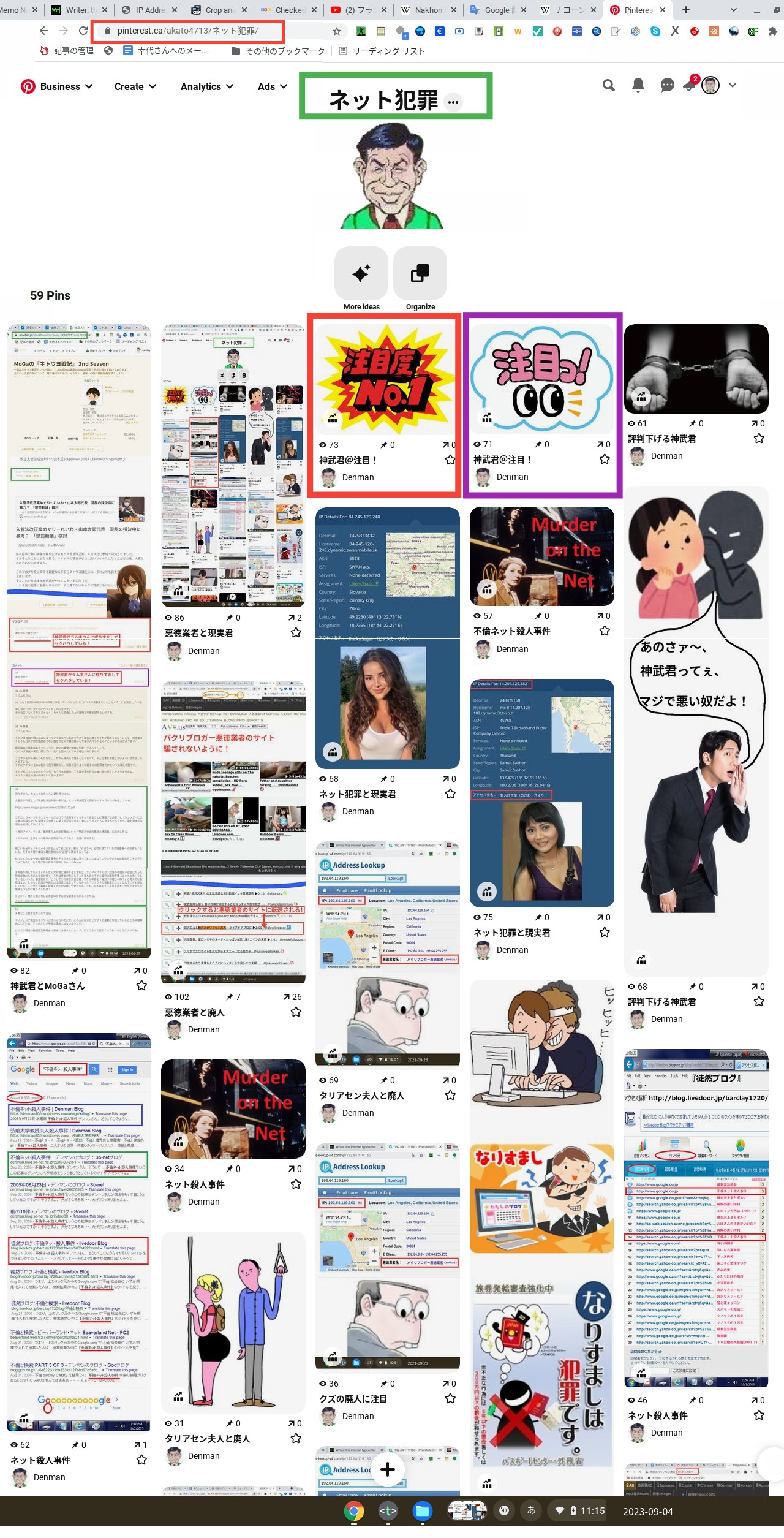

スパム・誤情報への悪用

Redditでは

ChatGPTを悪用したスパムが大量に発生しており、「大災害」と評されるほどに対応に苦慮している。

ChatGPTのリリース後、大麻やポルノ、ギャンブル、ゲームの宣伝を目的にしていると思われるスパムが急増し、モデレーターは大量のbotアカウントの凍結に追われた。

Redditでは従来も宣伝目的のスパムやアストロターフィングが問題だったが、ChatGPTはこの問題を大きく悪化させている。

従来のスパム行為はコピー・アンド・ペーストに依存して単純だったが、ChatGPTは新しい文面を簡単に生成できることから、より対処が困難になった。

2023年5月、ChatGPTを使って鉄道事故のニュースを捏造してインターネット上に拡散した男が、甘粛省の警察により逮捕された。

男は「クリック数を増やすためだった」と語った。

中国ではディープフェイクを規制する法律が制定されており、逮捕はこの法律に基づいたものだった。

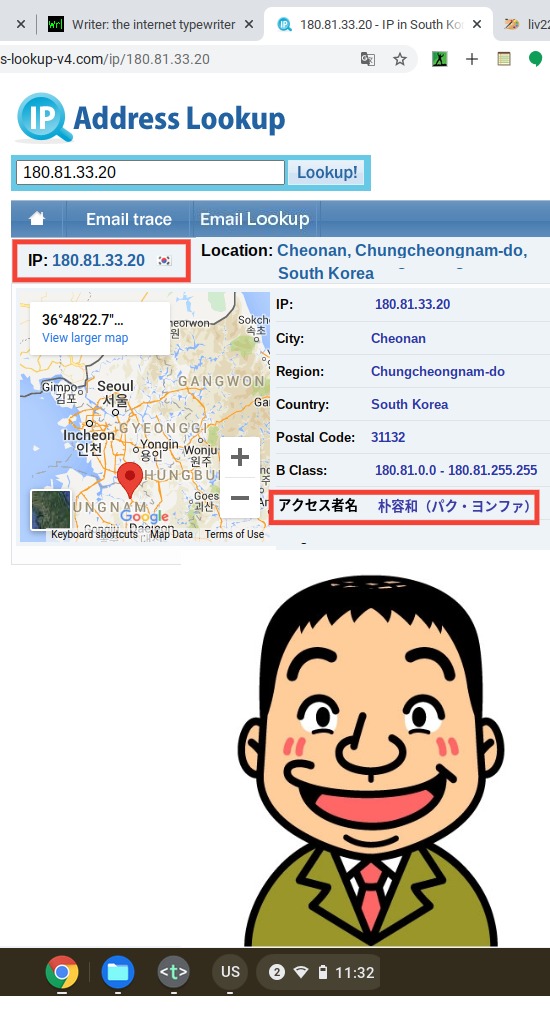

機密情報の流出

ChatGPTはオプトアウトを申請しない限り、ユーザーの入力内容がOpenAIによって利用されることが規約で明記されており、OpenAIは機密情報を入力しないようにユーザーに警告している。

サムスン電子では半導体データベースや機器のソースコード、会議の議事録などを社員が誤って入力するなどして、ChatGPTに関連する3件の流出事故が発生したことを報告し、全面的にChatGPTを含む人工知能ツールの使用を禁止した。

『フォーブス』誌によれば、プロンプトとして送信したデータが、OpenAI等の運営企業のサーバーに保存され、容易にアクセスや削除ができない状態になることを懸念したとされる。

Amazonでも、社内の内部データがChatGPTが生成する回答に似ている事例が見られたことから、社員が誤ってプロンプトに社外秘の資料等を入力するなどして、訓練データに使用された可能性を懸念し、ソースコード等の機密情報を入力しないように注意喚起を行っている。

Appleも、社内の機密データを外部に流出させる可能性があるという懸念から、ChatGPTやGitHub Copilotなどの人工知能ツールの使用を一部禁止している。

イスラエルの情報セキュリティ企業「Team8」の報告書では、ChatGPTのような生成AIツールを利用する企業は、顧客情報や企業秘密を流出させるリスクがあると指摘している。『ブルームバーグ』によれば、このレポートは多くの米企業の最高情報セキュリティ責任者が寄稿者として記載されており、米国家安全保障局(NSA)元局長のマイケル・ロジャーズにも内容が支持されている。

出典: 「ChatGPT」

フリー百科事典『ウィキペディア(Wikipedia)』

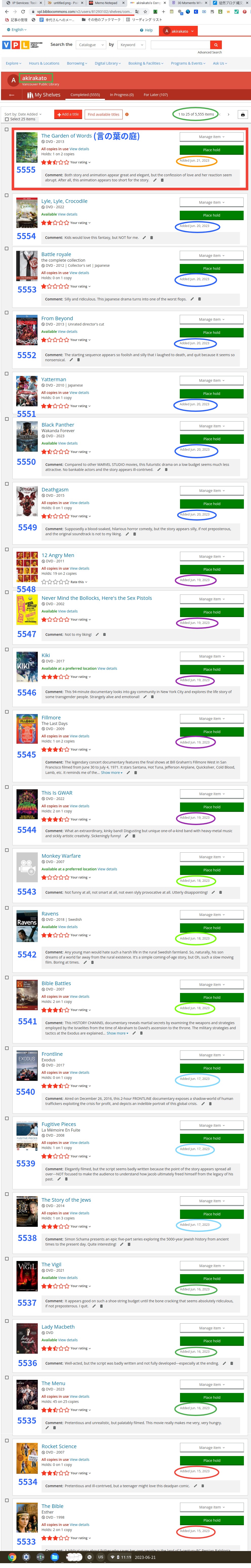

人類存亡のリスク

(aisoldier2.jpg)

AIは人類が制御不能なほどに自らの性能を向上させる可能性があるとされる

(aisoldier2.jpg)

AIは人類が制御不能なほどに自らの性能を向上させる可能性があるとされる。

著名なコンピューター科学者であるスチュアート・ラッセルとピーター・ノーヴィグによる大学レベルの標準的な教科書である『エージェントアプローチ人工知能』では、AIの危険性について、以下のように評価している。

AIの成功は人類の終わりを意味するかもしれない。

ほとんどどんな技術でも、使い方を誤れば害になる可能性がある。

しかし

AIとロボティクスについては、技術自体が間違いを含んでいるかもしれないという新しい問題がある。

物理学者のスティーブン・ホーキングも「人類の終わりを告げる」可能性を指摘した。

哲学者のニック・ボストロムは、十分に知的なAIが、ある目標の達成に基づいて行動を選択する場合、資源の獲得や停止されることから自身を守るなどの収束的行動を示すと論じている。

このAIの目標が人類の目標を完全に反映していない場合、より多くの資源を獲得したり、停止されるのを防いだりするために、最終的には人類に危害を加える可能性を指摘し、AIがどんなに謙虚で「友好的」な目標を掲げていたとしても、AIは人類にリスクをもたらすと結論付けている。

政治学者のチャールズ・T・ルービンは、「十分に高度な博愛主義は悪意と見分けがつかないかもしれない」とし、機械やロボットが人類の道徳システムを共有すると信じるアプリオリな理由がないため、機械やロボットが人類を好意的に扱うと仮定すべきではないと論じた。

AI関連の専門家や業界関係者の意見は千差万別で、かなりの割合が最終的に人間主体の管理が困難な性質を持つ高度に発展したAIの危険性を懸念する一方で、具体的な言及を控えて経済合理性などの商業的な観点から楽観的な立場を取る者も少なくない。

スティーブン・ホーキング、マイクロソフト創業者のビル・ゲイツ、歴史学者のユヴァル・ノア・ハラリ、スペースX創業者のイーロン・マスクらは、いずれも将来の高度に発展したAIの取り扱いについて深刻な懸念を表明している。

スティーブン・ホーキング「人工知能の発明は、人類史上最大の出来事だった。

だが同時に『最後』の出来事になってしまう可能性もある」

ビル・ゲイツ「これは確かに不安を招く問題だ。よく制御できれば、ロボットは人間に幸福をもたらせる。しかし、数年後、

ロボットの知能は充分に発展すれば、必ず人間の心配事になる」

イーロン・マスク「人工知能についてはかなり慎重にならないといけないと思います。おそらく人類の一番大きな脅威となりうるものですね。ですので、本当に慎重さが求められます。規制や監視が国レベル、あるいは国際レベルで必要だと思いますね。私たちが何か分別に欠けるようなことをしないためにね。人工知能は悪魔を呼び出すようなものですから」

この他にも、イーロン・マスクはAIについての深刻な懸念を繰り返し表明しており、「

悪魔のような独裁者は、少なくともいつかは死ぬ。だが、AIに死が訪れることはない。永遠に生きる。つまり、絶対に逃れることのできない不死身の独裁者が現れるようなものだ」として、永遠に破壊されることのない危険なAIを作り出す危険性を警告したほか、「AIが核兵器よりも危険なものとなる可能性がある」と表明している。

また、

AI開発を巡る国家間の競争を「第三次世界大戦の原因」になりうると指摘、AIは文明が直面する最大のリスクであると述べている。

ピーター・ティールとマスクを含む著名なハイテク企業は、OpenAIやFLIなどの責任あるAI開発を支持する非営利企業に10億ドル以上を出資している。

一方で、Facebookのマーク・ザッカーバーグは、人工知能は現在の形で役に立っており、今後も人類の助けになり続けると述べている。

リスクは研究する価値がないほど遠い将来である、あるいは超高知能AIから人類は便益を受けることになると主張する専門家もいる。

特にロドニー・ブルックスは「悪意ある」AIはまだ数世紀先だと述べている。

AI開発の権威であるヤン・ルカンは、AIが人類にとって深刻な脅威となる懸念に否定的な見解を示している。

人工知能学会の松尾豊は、著書『人工知能は人間を超えるか』内に於いて、人間に対して反乱を起こす可能性を否定している。

人工知能学会会長の野田五十樹は、「シンギュラリティ(技術的特異点)」や「2045年にAIが人間の知能を超える」という予測に対して「SFめいた話だ」と批判し、「そもそも“知能”が何を示すのか、定義をせずに語っても意味が無い。仮に知能が計算力を指しているのであれば、80年代からとっくに人間の能力を超えていることになる」と述べている。

2012年以前、社会学者ロバート・M・ゲラチは、AIとロボット工学(ロボティクス)を専攻しているカーネギーメロン大学の研究所を現地調査した結果、実際の研究はシンギュラリティ論とかけ離れた「世俗的現実」("the mundane reality")であると結論した。

同氏はカーツワイルやハンス・モラベックらのシンギュラリティ論を「終末論的AI」("Apocalyptic AI")と呼び、そのような論自体に対しては支持も反論もしないと前提した。

その上で、「終末論的AI」を大衆主義的な性質の強い通俗科学(pop science)の一種と見なしている。

つまりそれは宗教・エンターテインメント・フィクション等と同じような、分かりやすくて興味を刺激する説明を使い、大勢の興味を引いて研究費を獲得しているとし、「終末論的AIは、実際のところ、金銭の要求である。("Apocalyptic AI is, indeed, a request for money.")」と述べている。

2023年3月29日、OpenAI、マイクロソフト、Alphabetなどが対話型の人工知能を相次いでリリースしていることを受け、非営利団体のフューチャー・オブ・ライフ・インスティチュートは

ChatGPTが開発したGPT-4を超える性能の大規模言語モデルを応用した人工知能技術はAI倫理の専門家が安全性に関する規範を策定するまで開発を停止すべきという公開書簡を発表した。

書簡にはイーロン・マスク、DeepMindの研究者、Stable Diffusionを開発するStability AIとCEOのエマード・モスターク、ヨシュア・ベンジオ、スティーブ・ウォズニアックなど業界関係者ら1000人以上が署名している。

なお

OpenAI、マイクロソフト、Alphabetの幹部は署名していない。

Future of Life Instituteの書簡については、サイエンス・フィクション的であり、むしろ

現時点での人工知能のデメリットに注目すべきであるという批判がなされている。

プリンストン大学の研究者であるアーヴィンド・ナラヤナンとサヤシュ・カプールは、人工知能の現実的なリスクとして、不正確なツールへの依存による誤情報、中央集権的な権力と労働搾取による雇用への悪影響、セキュリティ上のリスクといった3点を重視すべきであると指摘し、元Googleの研究者であるティムニット・ゲブルはAIの現実的な害を軽減するために、透明性を強制する法規制の必要性を指摘した。

2023年5月、人工知能研究の第一人者として知られるジェフリー・ヒントンは、

想定より遥かに速くAIが進歩する危険性について自由に話すためとして、Googleを退社したことを公表した。

ヒントンは、

AIが偽の画像や文章を作成する能力を持ち「何が真実なのか分からなくなる」世界を作り出すことを懸念しており、「悪用をどのように防げばいいのか見当がつかない」と述べた。

ヒントンはGoogleは「責任を持って行動した」としており、Googleを批判する意図はないとしている。

ヒントンの退社を受け、オックスフォード大学AI倫理研究所のカリッサ・ベリズは、「

今こそAIを規制する時期だ」と述べた。

出典:「人工知能」

フリー百科事典『ウィキペディア(Wikipedia)』