誰でもいいので、スマートフォンが登場する前の暮らしを知る人に尋ねてほしい。当時の生活は今とは違っていた、という答えが返ってくるはずだ。だが、8年前に失明したNutsiri "Earth" Kidkulさんにとっては、生活が変わったという表現だけでは言い表せないほどモバイルアプリの影響は大きかった。

専門的なアプリが登場する前、Kidkulさんは、食料品の買い物や移動、文書の閲覧といった、健常者にとっては基本的な雑事をこなすために、今よりもはるかに入念な計画を立てて、準備をする必要があった。さらに、普段どおりの1日を過ごすために、ほかの人の助けを借りなければならないことも多かった。

「いつも彼らの時間やスケジュールに合わせる必要があった」(Kidkulさん)

Kidkulさんは、例えば、Microsoftの喋るカメラアプリ「Seeing AI」の力を借りて、自分のメールや文書を読むことができる。このアプリは十分な利便性と精度を備えているので、他者に頼る必要がなくなったと感じている。

「友人や家族の助けを借りずに自分のメールを分類したり、読んだりできるので、プライバシーが守られているという感じがする」(Kidkulさん)

過去10年間で、モバイルアプリは、おならの音を出すばかげたプログラムや頭を使う必要のないゲームから、人々の生活に大きな変化をもたらすサービスへと進化した。アクセシビリティーが急速に前面に押し出されるようになったのは、約2年半前のことだ。MicrosoftやAppleなどの大手企業がアクセシビリティーを優先事項にしたことがきっかけだった。これらのアプリは、表面的なユーザーインターフェースの改善だけでなく、人工知能(AI)や音声認識などの高度な技術を組み込むことで、メールの読み上げ機能のような実質的な有益性も提供する。

こうしたアプリは、より広範で多様なユーザーを考慮に入れることに献身的に取り組んでいる姿勢を示すものだ。とはいえ、ビジネス上の理由もある。技術のアクセシビリティーを高めることで、新しいユーザーを獲得したり、サービスの行き届いていないコミュニティーを無視することによる反発を避けたりすることができる。世界保健機関(WHO)の推計によると、2018年の時点で何らかの視力障害を抱える人は全世界で約13億人だったという。Kidkulさんは、3600万人いる全盲者の1人だ。

5月上旬に開催されたGoogleの開発者カンファレンス「Google I/O」で、同社は基調講演で少し時間を割いて、さまざまな新しい方法でアクセシビリティーに取り組んでいることを紹介した。Googleの最高経営責任者(CEO)のSundar Pichai氏は、動画や音声を文字に起こす「Live Caption」という機能や、AIを利用して発話障害のある人々を支援する「Project Euphonia」といったプロジェクトを発表した。

広がる新たな可能性

Kidkulさんは失明した後、視覚障害者向けにプログラムやセミナーを開催しているロサンゼルスの非営利団体Braille Instituteに学生として通い始めた。ボランティア活動に一層励むようになった後、同団体のテクノロジーインターンシッププログラムに参加した。そして、4年前から主任技術指導者を務めている。

Kidkulさんは、生活をより便利にしてくれるという、多くのアプリに頼っている。

「Instacart」は食料品の買い物を容易にし、「Money Reader」はKidkulさんが助けを借りずにさまざまな通貨を識別できるように支援する。買う必要のあるほとんどの商品は、Amazonを通して自宅に届けてもらえる。

公共交通機関で移動するときは「Smart Ride」を使用するが、それ以外の場合は、UberやLyftのアプリを使うという。

「移動の準備ができたら、UberかLyftを呼ぶだけで、自動車が自分の立っている場所まで迎えに来てくれる。ドライバーに運賃を払う必要もない(支払いはアプリを通して処理されるため)。この方がはるかに楽だ」(Kidkulさん)

AIを活用するアプリ

アクセシビリティー開発の目的は、単に新しいボタンや機能を追加することだけではない。多くのアプリには、全盲者や視覚障害者の日常生活を楽にする技術が組み込まれている。

「Be My Eyes」アプリはビデオ通話によって、晴眼者のボランティアと、援助を必要とするユーザーを結び付ける。ライブ通話では、食品の賞味期限やカメラを向ける場所を確認したり、色を区別したり、説明書を読んだりするのを助けることができる。

Kidkulさんが毎日使用するSeeing AIアプリは、人工知能を使って商品のバーコードや商品名、説明書、通貨を読み取る。さらに、このアプリは色やさまざまな物体の違いを区別するのにも役立つ。友達を認識できるようにしたり、周囲の人間の特徴を説明したりすることも可能だ(表情を識別することもできる)。

2019年に入って、中国のエレクトロニクス大手の華為技術(ファーウェイ)は、AI顔認識ソフトウェアで7種類の感情を識別できる「Facing Emotions」アプリをリリースした。AIに加えて、Facing Emotionsは同社の「Mate 20 Pro」のカメラも使用して、感情を耳で伝わる音に変換する。

Instagramも、アプリを全盲者や視覚障害者が利用しやすいものにする取り組みで、大きな進歩を遂げている。Instagramの現行のアプリには、代替テキストとカスタムの代替テキストが含まれる。自動代替テキストは画面読み上げ機能と連携して、写真がどういうものなのかをユーザーに説明する。

音声コマンドをサポートするアプリ

音声コマンドをアプリに組み込むことで、より安全に運転するといったアクションや天気情報を取得するなどの単純な作業が容易になる。これは、全盲者や視覚障害者のアクセシビリティーに極めて大きな変化をもたらす。

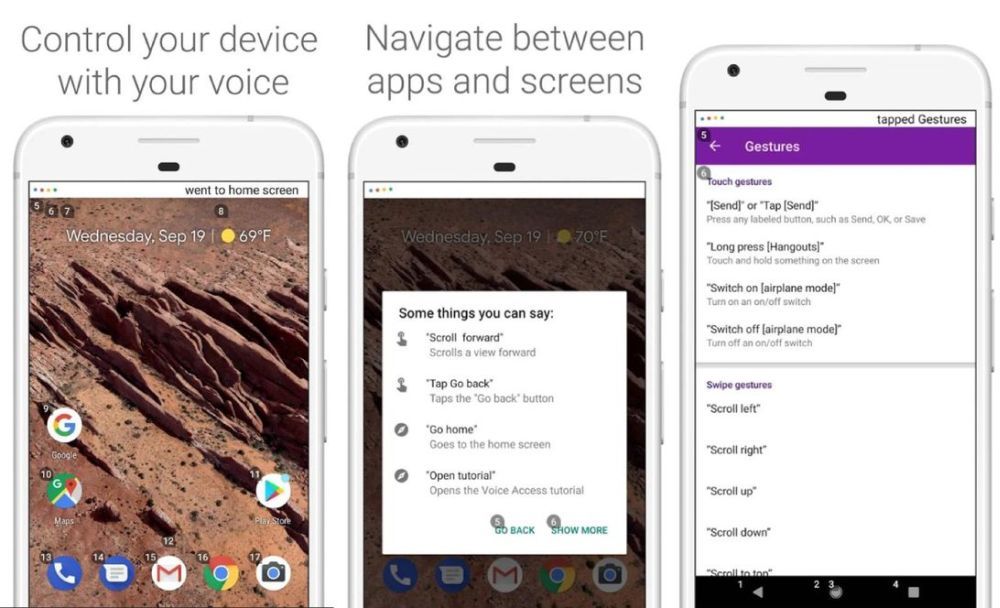

2018年10月、Googleのアクセシビリティーチームは「Voice Access」アプリを発表した。このプログラムにより、ユーザーは「Android」デバイスを完全にハンズフリーで操作できる。Voice Accessは音声コマンドで作動し、機能やアプリに番号を割り当てる。ユーザーは「OK Google」と言って、テキストの入力や画面のスクロール、アプリの操作などを実行できるようになっている。

このアプリは体の不自由な人向けに設計されているが、全盲者や視覚障害者にも有用かもしれない。

「Voice Access」アプリ 提供:Screenshot by Shelby Brown/CNET

「Voice Access」アプリ 提供:Screenshot by Shelby Brown/CNET この1年間に音声コマンド機能を追加または拡張したほかのアプリには、Android版YouTubeやPandoraなどがある。

GoogleはCES 2019で、Androidデバイスがロックされていても、「Googleアシスタント」が応答して機能するようになることを発表した。

車窓用の点字デバイス

Kidkulさんはライドシェアアプリと公共交通機関を利用しているが、将来的に、全盲者や視覚障害者にとってより大きな可能性があるのは、自動車の中かもしれない。

Fordは2018年5月、全盲者や視覚障害者が世界を「見える」よう支援する車窓用の点字デバイスを発表した。「Feel the View」は車窓の振動を利用して、外に何が見えるのかを伝える。

このプロトタイプ技術は、内蔵の外向きカメラで撮影した画像をグレースケールのイメージに変換する。グレーの濃淡が、さまざまな強度の振動に変換される。人が窓に触れると、その振動を点字のように感じることができる。

Feel the Viewには、音声アシスタントとAIも組み込まれており、画像の関連情報を提供することができる。

まだまだ先は長い

ロチェスター工科大学のKristen Shinohara助教授によると、アプリが進歩し続けても、スマートフォン自体にまだ問題があるという。Shinohara氏は同大学でCenter for Accessibility and Inclusion Research(アクセシビリティーおよびインクルージョン研究センター)の運営に携わっている。同氏が注力しているのは、障害者にも使える技術の設計だ。

Shinohara氏は電子メールの中で、次のように述べている。「幸い、スマートフォンアプリを視覚障害のあるユーザーにも利用できるようにする必要性について認識が高まりつつある、と言ってもいいだろう。だが、現在のスマートフォン技術でそうしたユーザーが利用できる機能を設計し、実装する方法については、まだ知識が不足している」

とはいえ、Kidkulさんはこれらの技術の成果も感じている。Kidkulさん自身、スマートフォンやデスクトップコンピューター、さらには視覚障害者向けメディアプレーヤー「Victor Reader Stream」や点字ディスプレイなどの補助デバイスの使い方を教えている。Kidkulさんによると、スマートフォンは、全盲者や視覚障害者がさまざまな場面で強いつながりや自立心を感じられるようにするという点で、大きな進歩を遂げているという。交通機関を含むさまざまな場所、友人や家族と連絡を取り合う場面、さまざまなものを購入したり識別したりする場面でそのように感じられるのだという。

「私はこれらのアプリの多くを自分で使用しているが、ここBraille Instituteの技術指導者として、テクノロジーは全盲者と視覚障害者の生活を一変させてきたと断言できる。私たちはスマートフォンを使って、晴眼者とほぼ同じことができる」(Kidkulさん)

しかし、改善の余地があるというShinohara氏の考えには、Kidkulさんも同意している。Kidkulさんによると、デバイス自体のアクセシビリティー機能を向上させ、アプリにアクセシビリティー要素を組み入れることに関して、開発者をもっと教育する必要があるという。例えば、ボタンや画像にラベルが付与されていないせいで、音声読み上げ機能の「VoiceOver」や「TalkBack」がそれらを識別できないことがよくある。さらに、Kidkulさんによると、地図は視覚的な要素が大きく関わっているため、改善の余地がある分野だという。

必要なのは、技術設計の考え方を根本から変えることである、とShinohara氏は言う。全盲者と視覚障害者だけを対象にアプリを設計するのではなく、アクセシビリティーを最初から開発プロセスに組み込む必要がある。

「適切な要素を作るということに注意を払っていれば、技術的には、ほぼすべてのアプリは全盲者と視覚障害者が使用できるものになる」(Kidkulさん)

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。

※コメント投稿者のブログIDはブログ作成者のみに通知されます