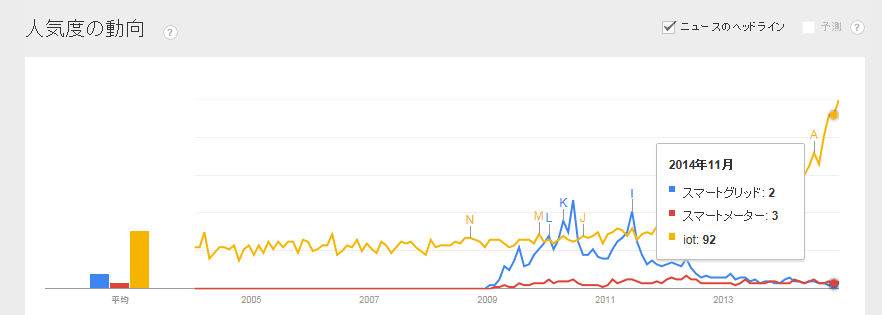

今日の夢が微妙な夢で、

「某社(夢の中では会社名が出ていたけど省略)

の心無いビッグデータ活用のあおりのおかげで、

一般の人は

どのようなデータを集めたら、

どのような分析が行え、

どのような効果が出るかわからず、

ビッグデータに投資した企業が没落し、社会が崩壊する・・・」

って感じなんだけど、

まあたしかに、

「どのようなデータをそろえると、

どのような分析が出来て、

どのくらい経営に貢献するか」

というのは誰も書いていないので、投資に失敗する可能性はあるわな・・・

(でも、社会は崩壊しないと思うけど・・)

というので、そんへんについて書いてみる。

今回は、主に流通(とくに小売)向け

実は、その夢に出てくるように、意外な結末になるのだ・・・

■データの種類-どのようなデータを集めたら

データ分析用のデータは、以下のようなものが必要で、

1から2,2から3と、順番に整備していかないと、

意味のないデータ解析になる危険性がある*。

1.売上データと商品データ

→バスケットレベルが吉、商品データが売上データに入っていれば、それでもよし

→そのとき何が店舗に出ていたかの情報があると(仕入れと在庫量が分かると出る)

吉なのだが、たぶん、そのデータは取れないので、なくてよい。

2.販促データ

→値引き、チラシ広告、景品、エンド陳列などの販促状況が分かるデータ

→売上データに入っていれば良いが、そうでない場合ヒモ付けが必要で

その際、店舗データが必要になるかも

3.IDつきPOSデータ

→2種類ある。顧客にアプローチできるCRMデータと、

顧客の個人情報が一切抜かれた属性データ。

4.ソーシャルデータ

SNSなど・・

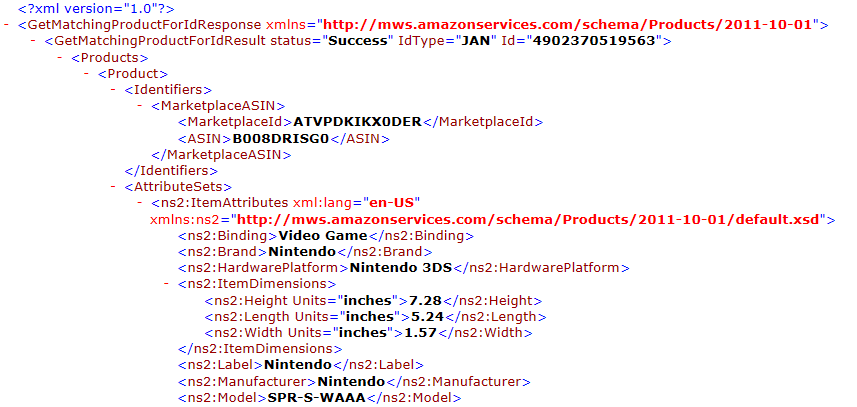

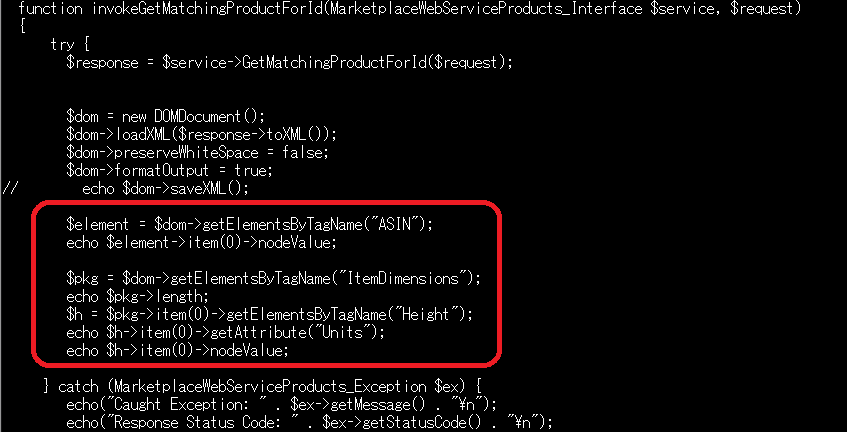

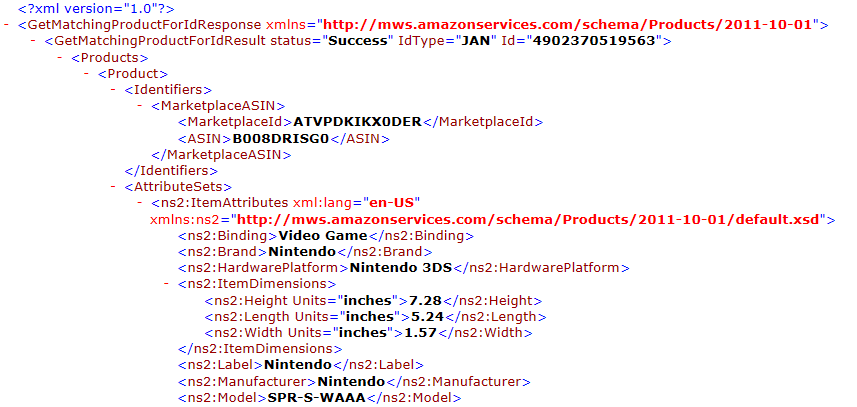

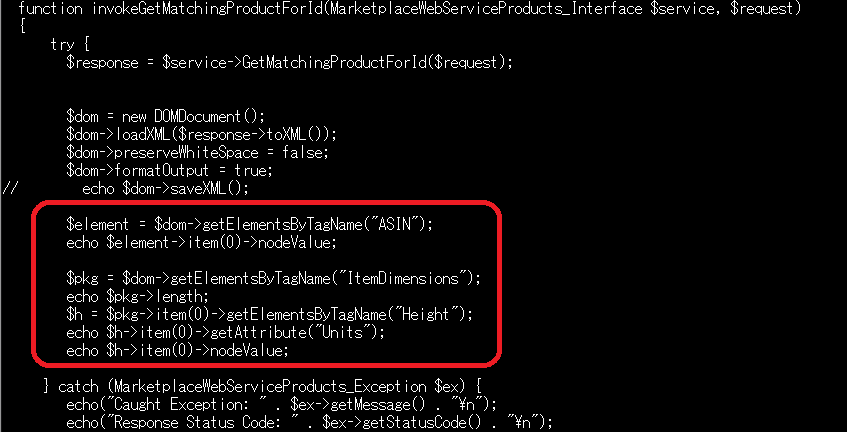

なお、有償のものも含めた、オープン(な)データ

(気象庁が出している天気データ、

流通システム開発センターが出している流通POSデータベースサービス(RDS)、

JANコード統合商品情報データベース(JICFS/IFDB)等)

は、どの段階でも、ある程度役立つ

*意味のないデータ解析

たとえば、3.IDつきPOSデータを使い、「50台女性は商品Aを購入する」というデータ

が出たとき、じゃあ50代女性がこのスーパーの顧客に多いから、Aは売れるはず

・・・と解釈してしまうかもしれない。

この場合、Aをチラシに出して特売すると、50代女性はチラシを見てわざわざ

買いに来ているかもしれない。これは2.販促データがないと、わからない。

なので、販促で売れているような場合、IDつきPOSデータだけで判断すると、

意味のない結果が出たり、間違った判断をしたりする。

■データ解析法-どのような分析が出来て

集めるデータによって、分析範囲が異なってくる。

●1.売上データと商品データ

・売上データから、まず、売上傾向とトレンドや季節性について見れる

(前年より、よい・わるい)

商品分析に入る前に、全体の売上傾向を見ておく。

そうでないと、「不況だから売れない」のか「商品力がなくなったから売れない」

のか判断できないから。

・次に売上商品ごとのランキング、前年期比などをみて、調子いい商品、

調子悪い商品の全体傾向を知る。

→ABC分析等も、ここで

ただし、売上をみるときは、「欠品していないかどうか」や売り場面積も

確認(意識)しておくこと。

うれるはずの商品が売れていない→売れすぎて欠品していたから

ってこともあるので。

- ここまでは、グラフや表を使った、基本的な分析(記述統計レベル)となる -

・商品ごとのアソシエーションをみるために、バスケット分析をすることもできる

バスケット分析は、

・すべてのバスケット全組み合わせ(A,B,Cを買った人はDを

買うのような、2種類以上の組み合わせ)を見たい場合には、

アプリオリというプロトコルを使う。Rで解析できる

・組み合わせだけでよければ(Aを買った「バスケット内では」Bも買っている)

RDBでも量が少なければ見れる。

自己結合を使い、

SELECT TBL_A.商品 TBL_B.商品

FROM 売上テーブル AS TBL_A

JOIN 売上テーブル AS TBL_B

on TBL_A.バスケット番号=TBL_B.バスケット番号

WHERE TBL_A.商品 != TBL_B.商品

とすると、TBL_AとTBL_Bのバスケット内商品の直積がとられ、全組み合わせが出てくる

なので、こいつをカウントする。

・でも、もっと簡単に商品Aを含んでいるバスケット内には、他に何がある?

というのを見たいのなら

SELECT TBL_A.商品

FROM 売上テーブル AS TBL_A

JOIN 売上テーブル AS TBL_B

on TBL_A.バスケット番号=TBL_B.バスケット番号

AND TBL_B.商品=知りたい商品

WHERE TBL_A.商品 != 知りたい商品

で出てくる。

・このほか、コーザルデータ(天候や地域行事)を加えて、

こういうときは、売れるというのを見ることもできる

機械学習でもいいけど、まあ、ざっくりと

アイスクリーム 気温30度以上のとき、そうでないとき

をわけてグラフ表示・ピボットテーブル(クロス表)してもいい。

・流通システム開発センターのRDSを使うと、比較が出来るかも?

●2.販促データ

・どのような販促を打ったら、効果あったかないかがわかる。

これも、コーザルデータのときのように

ある商品に対して

販促Aを行った、行わない

をわけてグラフ表示・ピボットテーブル(クロス表)してもいい。

・値下げをしている場合、価格によって、売れ行きがどうかというのが見れる。

ヒストグラムで見るのが普通かもしれないけど、

Xを価格、Yを売れた数にして、散布図で見るという手もある。

●3.IDつきPOSデータ

◎IDだけを使う場合、「1.売上データと商品データ」よりも細かい

商品情報が見れる

・デシル分析:購買者を購買金額上位からならべて、ほぼ10等分し、

各階層で、ある商品をどれくらい買っているか見る。

顧客をデシルに分けるには、NTILEウィンドウ関数で分けられる

・RFM分析:さらに顧客をR(最近買った日)、F(買った回数)、

M(類型金額)によって、分類し、その各階層で、どの商品

をどれくらい買っているか見る。

上記のようにSELECT文でNTILEウィンドウ関数で分けてがんばる!

・

トライアルリピート

商品をはじめて買った人(トライアル)、2回目以上買った人(リピート)に

わけ、どのくらいの人が買っているかを見る。

リピートを2回にするか、2回「以上」にするかの違いが有り、

2回の場合は、主に商品力を見たいケース

2回以上の場合は、棚割りで、棚から削除すべきかどうかの判断

につかう。

SELECTにLEADウィンドウ関数(OVER 販売日時)を使うと、次の購買日が

出せる。それを利用するのかな・・

・アソシエーション分析(Aを買った人はBを買っています)

バスケット分析はバスケット内で判断するが、これは期間内で判断する

Aを買った人は次の日Bを買っていた場合、バスケット分析ではカウント

しないが、これはカウントする。

バスケット分析の「バスケット」を「人」に代えただけだが、

全部求めると(直積すると)すごいことになるので、普通

商品Aを買った人は、何を買う?ということで

SELECT TBL_A.商品

FROM 売上テーブル AS TBL_A

JOIN 売上テーブル AS TBL_B

on TBL_A.顧客ID=TBL_B.顧客ID

AND TBL_B.商品=知りたい商品

WHERE TBL_A.商品 != 知りたい商品

で出てくる。

・ロイヤリティ?スイッチャー?

その人が、同じカテゴリーの商品を買う場合、同じ商品を買っているか、

違う商品を買うことが多いかを出す

SQL的には、知りたい商品のカテゴリーをもとめ、そのカテゴリー全商品

に対して、各商品の売上合計を求めれば求まるが、

欠品のために他の商品を買っていることもあるので、注意が要る

◎属性値も含む場合、属性情報を使った販売情報が見れる・・・ことになっている

Aという商品は、20代女性の購入が多いなど

●4.ソーシャルデータ

Twitterの情報を加えると、購入していない人の情報までも取得できると

言われている

たとえば、Aという商品が売れない場合、TwitterのつぶやきでAという商品

を解析すると、その商品が売れない理由が分かったりすると「言われている」

■どのくらい経営に貢献するか

●1.売上データと商品データ

商品の売上状況が分かると、今後どのくらい仕入れたらよいかの予測がつけられる

とくに、コーザルデータとあわせて、「明日運動会だから、もっと仕入れる」など、

より精度の高い予測がつけられる。

さらに、アソシエーション情報が分かると、チラシなどの広告や、販促を行ううえで

役に立つ。この商品を売りたいから、これも広告に載せておこう、セット販売しよう

など。とくにリフト率が分かると、これがやりやすい

●2.販促データ

販促に意味があったのかなかったのか、値下げは無駄だったのか、そうでないのかが

わかる。値下げはむやみにするものではないので、値下げたぶん、売れていないのであれば

値下げすべきでない。

販促効果があったかなかったかは、リフト率を見れば分かるが、クロス表でも

まあ、雰囲気はつかめる・・

●3.IDつきPOSデータ

これは、IDだけを使うのであれば、「1.売上データと商品データ」と同じ

効果が期待できる。

しかし、属性情報がわかっても、顧客理解はすすむが、経営に資するかどうかは

わからない。

たとえば、「育毛剤は、30、40代女性が多く購入している」

というデータが出て場合、ご主人のために買っているのだろうなという

想像がつき、顧客理解はすすむ。

でも、その情報から、どのように販促したらいいのかがわからない。

個人情報つきの場合には、DMを打つなどの方法もあるのだが、

そのような情報のない、属性データの場合、どのように販売に

結びつけるか・・・意外と難しい。

●4.ソーシャルデータ

もっと難しいのが、ソーシャルデータで、これに至っては、

売れない理由はわかっても、では、なにをどうすれば・・・

途方にくれてしまったりする。

もちろん、お店のTwitterをするという手もあるけど、

それはデータ分析とは関係ない

ということで、実は、IDつきPOSデータや、ソーシャルデータは、

お金がかかる割りに、経営に資するものかどうかは、疑問だったりする。

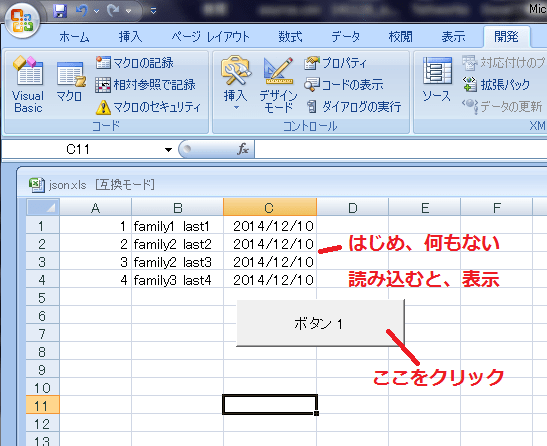

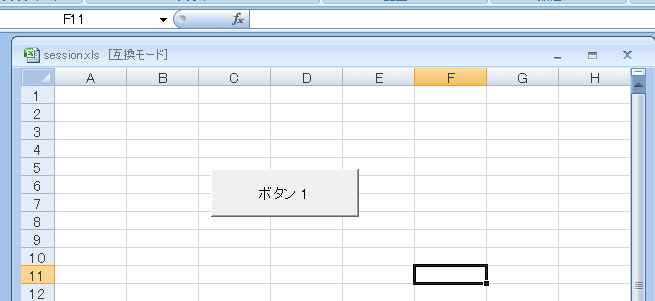

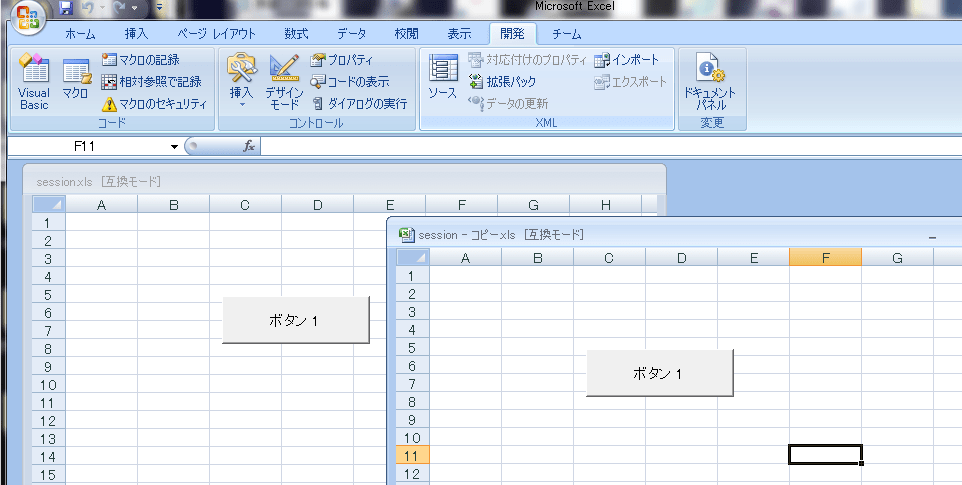

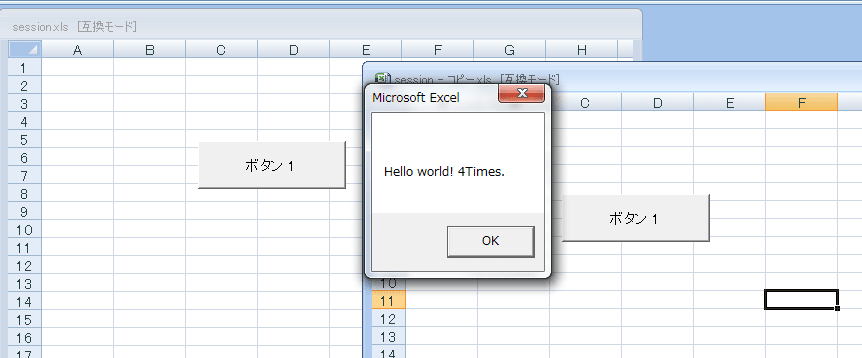

「1.売上データと商品データ」「2.販促データ」の解析はExcelで

すんでしまうわけで、そうすると、ビッグデータは本当に経営に役立つか・・・

・・・投資しただけ、回収できず損になる・・・

・・っていう夢なわけでした・・

ウィリアムのいたずら @xmldtp

ウィリアムのいたずら @xmldtp